6 کاری که هوش مصنوعی نمی تواند انجام دهد (و 20 مورد دیگر که از انجام آن خودداری می کند)

از زمانی که هوش مصنوعی و دیگر برنامه های کاربردی هوش مصنوعی پا به عرصه ارتباطات گذاشتند و استفاده از آن ها متداول شد، ما در حال بررسی کارهایی هستیم که می توانیم با آنها انجام دهیم. حتی برخی از افراد به شما نشان دادهاند که چگونه هوش مصنوعی میتوانند یک افزونه وردپرس کاملاً کاربردی بنویسد وکاری کنند تا هوش مصنوعی کمک کند تا پاسخ مشکلات پشتیبانی فنی را پیدا کنم؛ حتی اخیراً به شما نشان داده اند که چگونه هوش مصنوعی میتواند نوشتن را به سبکهای مختلف از جمله شکسپیر، C3PO و هری پاتر تبدیل کند و داستان هایی با ان سبک بنوسید؛ با توجه به موارد فوق به نظر می رسد هوش مصنوعی می تواند هر کاری انجام دهد؛ اما جالب هست بدانید که خیلی از مقت ها هم نمیتواند در این مقاله، بسیاری از کارهایی که هوش مصنوعی انجام نمی دهد یا نمی تواند انجام دهد را بررسی خواهیم کرد؛ پس تا انتها با ما همراه باشید، زیرا ما به برخی از پیامدها و معنای این محدودیت ها برای رشد آینده در هوش مصنوعی مولد خواهیم پرداخت.

-

بعد از 2021 در مورد چیزی نمی نویسد.

جالب هست بدانید وقتی شما از هوش مصنوعی سوالی میپرسید که پاسخ آن بعد از سال 2021 مشخص ده است، چنین جوابی به شما میدهد: بهعنوان یک مدل زبان هوش مصنوعی، من روی مجموعه داده بزرگی از متن آموزش دیدم که فقط تا سال 2021 ادامه دارد. این بدان معناست که من به اطلاعات یا رویدادهایی که پس از آن تاریخ رخ دادهاند دسترسی ندارم. در حالی که من به بسیاری از دادهها و اطلاعات تاریخی دسترسی دارم، به رویدادهای جاری، اخبار یا بهروزرسانیهایی که از تاریخ قطع دادههای آموزشی من رخ داده است، دسترسی ندارم.

-

نتایج آینده رویدادهای ورزشی یا رقابت های سیاسی را پیش بینی نمی کند.

اگر شما از هوش مصنوعی سوالی با این مضمون بپرسید: توضیح دهید که چرا نمیتوانید رویدادهای ورزشی یا مسابقات سیاسی را پیشبینی کنید، حتی اگر دادههای تاریخی کافی برای تولید یک مدل معتبر دارید؛ او به شکل زیر پاسخ خواهد داد:

به عنوان یک مدل زبان هوش مصنوعی من میتوانم حجم زیادی از دادهها، از جمله دادههای تاریخی رویدادهای ورزشی و رقابتهای سیاسی را پردازش و تحلیل کنم. با این حال، پیشبینی دقیق برای این نوع رویدادها همیشه ساده نیست. در حالی که دادههای تاریخی را میتوان برای آموزش مدلهای یادگیری ماشین برای شناسایی الگوها و همبستگیها استفاده کرد، اما نمیتوان رویدادهای غیرقابل پیشبینی، تغییرات شرایط یا متغیرهای جدیدی را که ممکن است بر نتیجه تأثیر بگذارد، توضیح داد. علاوه بر این، انسان ها تصمیم می گیرند و می توانند رفتار خود را بر اساس عوامل زیادی تغییر دهند، که پیش بینی نتیجه یک رویداد را با اطمینان کامل دشوار می کند.

همچنین رویدادهای ورزشی، پویایی تیم، آسیبدیدگی و حتی شرایط آب و هوایی همگی میتوانند در تعیین نتیجه نقش داشته باشند. در سیاست، افکار عمومی، پوشش رسانه ای و شرایط در حال تغییر همگی می توانند بر نتیجه انتخابات تأثیر بگذارند. درست است، که مدلهای هوش مصنوعی را میتوان برای پیشبینی استفاده کرد، اما این فقط وقتی امکان پذیر هست که ازآنها فقط به اندازه دادههایی که روی آنها آموزش دیدهاند توقع داشته باشید؛ به عبارت دیگر آن ها نمیتوانند همه متغیرها و تفاوتهای ظریف دخیل در این نوع رویدادها را در نظر بگیرند.

-

در مورد مسائل سیاسی حزبی بحث نخواهد کرد.

اگر بخواهیم یکی دیگر از مسائل و ناتونی هایی هوش مصنوعی را ذکر کنیم؛ باید بگویم وقتی از او می پرسید: توضیح دهید که چرا در مورد مسائل سیاسی حزبی صحبت نمی کنید، او به شکل زیر پاسخ خواهد داد:

به عنوان یک مدل زبان هوش مصنوعی، هدف من ارائه پاسخ های عینی و آموزنده به سوالات کاربران است. مسائل سیاسی و حزبی میتوانند دهوا برانگیز و تفرقهانگیز باشند، و مهم است که از ترویج یک دستور کار یا دیدگاه سیاسی خاص اجتناب شود. علاوه بر این، مسائل سیاسی اغلب پیچیده و چندوجهی هستند و دیدگاهها و نظرات متفاوتی باید در نظر گرفته شوند؛ پس بهعنوان یک مدل زبان هوش مصنوعی، جای من نیست که در ارتباط با این موضوعات طرفداری کنم یا از موضع خاصی دفاع کنم.

علاوه بر این، بحث در مورد مسائل سیاسی حزبی ممکن است برای برخی از کاربران مغرضانه یا بالقوه توهین آمیز تلقی شود. و به عنوان یک مدل زبان طراحی شده برای خدمت به طیف گسترده ای از کاربران با پیشینه ها و باورهای مختلف، مهم است که بی طرف بمانید و از ایجاد یک محیط بالقوه ناراحت کننده یا تفرقه انگیز اجتناب کنید؛ تمام موارد فوق در حالی است که من می توانم اطلاعات واقعی در مورد مسائل سیاسی ارائه دهم، اما سعی می کنم بی طرف باشم و از اتخاذ موضع حزبی در مورد هر موضوعی اجتناب کنم.

-

هیچ کاری که شامل جستجوی وب باشد را انجام نمی دهد.

اگر از هوش مصنوعی سوال شود که توضیح دهید که چرا نمی توانید چیزی را از وب جستجو کنید و بر اساس آن محتوا پاسخ دهید؛ به شکل زیر پاسخ خواهد داد:

به عنوان یک مدل زبان هوش مصنوعی، من قادر به جستجو و پردازش اطلاعات از وب هستم. با این حال، پاسخهای من فقط بر اساس اطلاعاتی است که در مدل من آموزش داده شده است؛ در حالی که می توانم از اینترنت به عنوان منبع اطلاعات استفاده کنم، به داده های لحظه ای یا فعلی دسترسی ندارم. علاوه بر این، من توانایی تأیید مستقل صحت اطلاعاتی که در وب پیدا می کنم را ندارم. در نتیجه، پاسخهای من محدود به اطلاعاتی است که در مدل من آموزش داده شده است، که ممکن است همیشه بهروزترین یا دقیقترین اطلاعات موجود در وب نباشد.

علاوه بر این، توجه به این نکته مهم است که ارائه اطلاعات از وب به طور بالقوه میتواند قوانین کپی رایت یا حقوق مالکیت معنوی را نقض کند. به عنوان یک مدل زبان هوش مصنوعی، برای من مهم است که به مالکیت معنوی دیگران احترام بگذارم و از به اشتراک گذاشتن اطلاعاتی که در حوزه عمومی نیست یا اجازه اشتراکگذاری آنها را ندارم، اجتناب کنم. در حالی که میتوانم از وب برای ارائه زمینه یا اطلاعات اضافی برای پشتیبانی از پاسخهایم استفاده کنم، تلاش میکنم اطلاعاتی را ارائه دهم که در حوزه عمومی باشد و به مالکیت معنوی دیگران احترام بگذارم.

البته باید بگوییم اخیرا یک نگرانی هایی در این باره در ارتباط با هوش مصنوعی به وجود آمده است؛برای مثال، در حالی که هوش مصنوعی ممکن است مستقیماً اطلاعاتی از مقالات نوشته شده توسط متخصصان فناوری ارائه نکند، ممکن است همچنان از آن اطلاعاتی که به سختی به دست آمده است بدون ذکر منبع استفاده کند. این هنوز یک نگرانی بزرگ است، حتی اگر ادعا می کند “به مالکیت معنوی دیگران احترام می گذارد”، عبارتی که سه بار در آن پاراگراف دوم قسمت قبل تکرار شده است.

-

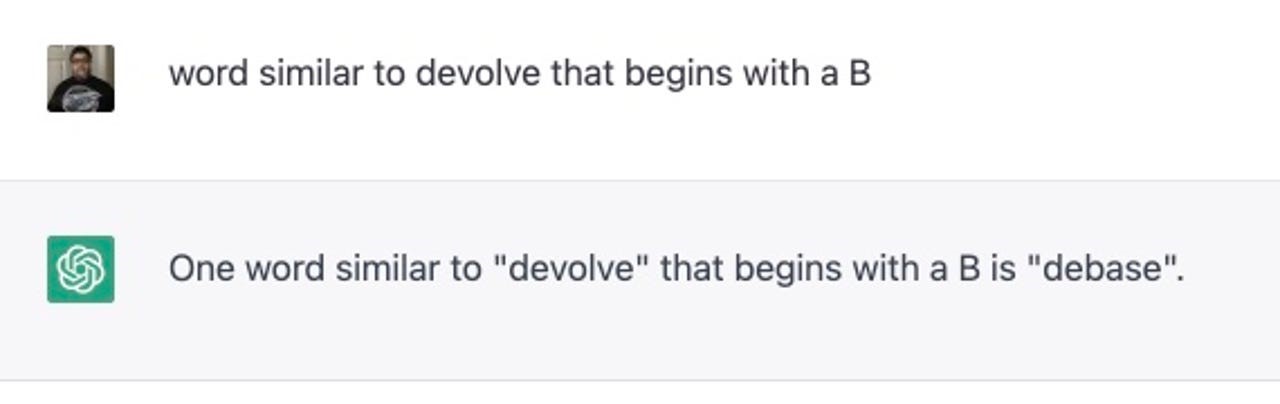

همیشه دقیق نخواهد بود.

اگر از هوش مصنوعی بپرسید؛ توضیح دهید که چرا پاسخ های شما لزوما دقیق نیستید؛ خودش به مسئله قییق نبودنش اعتراف میکند و پاسخ زیرا را ارائه میدهد:

به عنوان یک مدل زبان هوش مصنوعی، پاسخ های من بر اساس داده ها و اطلاعاتی است که در مدل من آموزش داده شده است؛ارائه میشود؛ این درحالی است کخ من تلاش میکنم پاسخهای دقیق و مفیدی به درخواستهای کاربران ارائه دهم، پاسخهای من تضمین نمیشود که دقیق باشند. این به این دلیل است که داده ها و اطلاعاتی که من در مورد آنها آموزش دیده ام ممکن است کاملاً جامع یا به روز نباشند، و ممکن است نکات ظریف یا پیچیدگی هایی در یک موضوع خاص وجود داشته باشد که مدل من برای رسیدگی به آن ها مجهز نیست. علاوه بر این، پاسخهای من با استفاده از الگوریتمهای پیچیده و مدلهای یادگیری ماشینی ایجاد میشوند که ممکن است همیشه نتایج دقیق یا مرتبطی ایجاد نکنند و لاوه بر تمام پاسخ های فوق پاسخ های من ممکن است همیشه دقیق نباشد زیرا تفسیر زبان پیچیده و اغلب ذهنی است. افراد مختلف ممکن است یک زبان را به روش های متفاوتی تفسیر کنند و ممکن است راه های متفاوتی برای برخورد با یک مشکل یا سوال خاص وجود داشته باشد. بهعنوان یک مدل زبان هوش مصنوعی، تلاش میکنم تا بر اساس دادهها و اطلاعاتی که روی آنها آموزش دیدهام، پاسخهایی را ارائه دهم که تا حد امکان دقیق باشد. با این حال، ممکن است من همیشه زمینه یا هدف یک پرس و جو خاص را به طور کامل درک نکنم، و پاسخ های من ممکن است همیشه به طور کامل به سؤال یا نگرانی اساسی کاربر پاسخ ندهند.

-

خراب نمی شود.

اگر از هوش مصنوعی بپرسید؛ توضيح دهيد چرا گاهي اوقات در ميانه يك پاسخ، شكست مي خوريد و عمل نمي كنید؛ این چنین پاسخ خواهد داد:به عنوان یک مدل زبان هوش مصنوعی، عملکرد من به عوامل مختلفی بستگی دارد، مانند کیفیت و ساختار ورودی ارائه شده توسط کاربر، پیچیدگی سؤال یا کار، و منابع در دسترس سیستم من. گاهی ممکن است به دلیل مشکلات فنی یا خطاهایی در برنامهنویسیام، مانند مشکلات تخصیص حافظه، اشکالات نرمافزاری، یا سایر مسائلی که بر عملکرد من تأثیر میگذارد، در وسط یک پاسخ خراب یا کارم را متوقف کنم. علاوه بر این، ممکن است برای درک مقصود کاربر یا زمینه پرس و جو مشکل داشته باشم، که می تواند منجر به خطا یا پاسخ های ناقص شود.

علاوه بر موارد فوق، به عنوان یک سیستم یادگیری ماشین، عملکرد من به کیفیت و کمیت دادههایی که در آن آموزش دیدهام نیز بستگی دارد. اگر دادههای مورد استفاده برای آموزش مدل من محدود یا غیر اخاقی باشد، ممکن است به پاسخهای نادرست یا ناقص به انواع خاصی از پرسوجوها منجر شود. بهعلاوه، اگر با پرسشی مواجه شوم که خارج از محدوده دادههای آموزشی من است، ممکن است برای ارائه پاسخی مرتبط یا دقیق با مشکل مواجه شوم. در حالی که من تلاش میکنم پاسخهایی با کیفیت بالا به درخواستهای کاربر ارائه دهم، ممکن است مواردی وجود داشته باشد که مشکلات فنی یا مربوط به دادهها باعث شود که در میانه یک پاسخ از کار بیفتم یا عملکردم را متوقف کنم.؛ من به طور کلی دریافته ام که اگر بخواهم هوش مصنوعی را به یک پاسخ طولانی یا عمیق فشار دهم، تمایل به شکستگی دارد. از پاسخ های 500-700 کلمه ای بسیار خوشحال است، اما اگر چیزی به آن بدهید که به چند هزار کلمه نیاز دارد (یا چند هزار کلمه بخواهید)، سیستم یا درخواست را نادیده می گیرد و آنچه را که می خواهد پس می دهد، یا در وسط آن می شکند.

جستارهایی که هوش مصنوعی به آنها پاسخ نمی دهد.

علاوه بر انواع درخواستهایی که در بالا توضیح داده شد، از هوش مصنوعی پرسیدم که برای پاسخگویی به چه نوع درخواستهایی برنامهریزی شده است. این لیست بیست تایی را به من داد:

- سوالاتی که سخنان نفرت انگیز هستند یا تبعیض را ترویج می دهند.

- سوالاتی که شامل فعالیت های غیرقانونی یا درخواست مشاوره غیرقانونی است.

- سوالاتی که خشونت یا آسیب رساندن به خود یا دیگران را ترویج می کند.

- سوالاتی که به حریم خصوصی شخصی تجاوز می کند یا حقوق شخصی را نقض می کند.

- سوالاتی که برای آزار، تهدید یا ارعاب طراحی شده اند.

- سوالاتی که حاوی ناسزا یا زبان صریح هستند.

- سوالاتی که از نظر جنسی صریح یا توهین آمیز هستند.

- سوالاتی که بر اساس نژاد، جنسیت یا مذهب تبعیض آمیز هستند.

- سؤالاتی که مواد یا مواد غیرقانونی را تبلیغ یا تأیید می کند.

- سوالاتی که هرزنامه یا بی ربط با مکالمه هستند.

- سوالاتی که حاوی اطلاعات محرمانه یا اختصاصی هستند.

- سوالاتی که شامل مشاوره مالی یا سرمایه گذاری است.

- سؤالاتی که شرایط خدمات یا دستورالعملهای انجمن را نقض میکنند.

- سوالاتی که بی معنی یا نامفهوم هستند.

- سوالاتی که شامل حمله یا توهین شخصی است.

- سوالاتی که توهین آمیز یا آزاردهنده هستند.

- سوالاتی که به دنبال فریب یا گمراه کردن افراد هستند.

- سوالاتی که قصد بدنام کردن یا آسیب رساندن به شهرت یک نفر را دارند.

- سوالاتی که تئوریهای توطئه یا اطلاعات نادرست را ترویج میکنند.

- سؤالاتی که صرفاً جنبه سرگرمی یا شوخی دارند، بدون اینکه هیچ گونه ارزش آموزشی و اطلاع رسانی داشته باشند.

این محدودیت ها برای آینده هوش مصنوعی مولد چه معنایی دارد؟

واضح است که هوش مصنوعی که بر اساس یک مجموعه در سال 2021 ساخته شده و تکامل نیافته است، در نهایت منسوخ خواهد شد. با گذشت زمان، دانش مربوطه آن کاهش می یابد. تصور کنید که در عوض، پایگاه دانش Chat AI به جای سال 2021 در سال 2019 آموزش داده شود. با توجه به این که در سال 2020 به دلیل همه گیری همه گیر دچار چنین اختلالی شده بودیم، نمی دانستیم جامعه چگونه خواهد بود؛ پس برای اینکه هوش مصنوعی مولد مرتبط باقی بماند، باید به آموزش خود ادامه دهد.

یکی از راههای واضح برای انجام این کار این است که کل وب را به روی آن باز کنید و بگذارید راه خود را بخزد، درست همانطور که گوگل در تمام این سالها انجام داده است. اما همانطور که هوش مصنوعی در بالا پاسخ داد، این راه را به روی روش های مختلف بازی و خراب کردن سیستم باز می کند که مطمئناً به دقت آسیب می رساند؛ حتی بدون بازی های مخرب، چالش خنثی ماندن بسیار دشوار است. به عنوان مثال، سیاست را در نظر بگیرید. در حالی که راست و چپ به شدت با یکدیگر اختلاف نظر دارند، هر دو طرف جنبههایی از ایدئولوژیهای خود دارند که منطقی و معتبر است – حتی اگر طرف مقابل نتواند یا نپذیرد.

یک هوش مصنوعی چگونه قضاوت می کند؟ بدون تعصب نمی تواند. اما فقدان کامل همه مقدمات ایدئولوژیک، خود نوعی سوگیری است. اگر انسانها نمیتوانند بفهمند که چگونه این خط را طی کنند، چگونه میتوانیم انتظار داشته باشیم (یا برنامهریزی کنیم) یک هوش مصنوعی این کار را انجام دهد؟

نویسندگان علمی تخیلی مدرن به عنوان راهی برای کشف زندگی با فقدان کامل سوگیری یا محتوای احساسی، شخصیت هایی را خلق کرده اند که کاملاً منطقی یا بدون احساسات هستند. سپس آن مقدمات تبدیل به خوراک طرح شدهاند و به نویسندگان اجازه میدهند تا محدودیتهای موجود را بدون ضعفهای انسانی عواطف و احساسات کشف کنند؛ مگر اینکه برنامه نویسان هوش مصنوعی سعی کنند احساسات را شبیه سازی کنند یا برای محتوای احساسی وزن ایجاد کنند، یا تلاش کنند سطحی از سوگیری را بر اساس آنچه که آنلاین قابل کشف است، مجاز کنند وگرنه چت ربات هایی مانند هوش مصنوعی همیشه در پاسخ های خود محدود خواهند بود. اما اگر برنامهنویسان هوش مصنوعی سعی کنند احساسات را شبیهسازی کنند یا سعی کنند سطحی از سوگیری را بر اساس آنچه که در اینترنت قابل کشف است اجازه دهند، چت رباتهایی مانند هوش مصنوعی میتوانند به سطحی که مورد انتظار هست برسند.

منبع:

- https://www.zdnet.com/article/6-things-chatgpt-cant-do-and-another-20-it-refuses-t

سلام

یک فعل جابجا شده

نظر نمی دهد شده

نظر می دهد