ماشین لرنینگ چیست؟

راهنمای جامع مبانی و کاربردهای ماشین لرنینگ

ماشین لرنینگ (یادگیری ماشینی) چیست؟

ماشین لرنینگ شاخهای از علوم کامپیوتر است که به رایانهها اجازه میدهد به طور خودکار الگوها را از دادهها استنتاج کنند بدون اینکه به صراحت گفته شود که این الگوها چیست. این استنتاج ها اغلب مبتنی بر استفاده از الگوریتم هایی برای بررسی خودکار ویژگی های آماری داده ها و ایجاد مدل های ریاضی برای نشان دادن رابطه بین کمیت های مختلف است.

بیایید این را با محاسبات سنتی مقایسه کنیم، که بر سیستمهای قطعی تکیه میکند، که در آن به صراحت مجموعهای از قوانین را برای انجام یک کار خاص به رایانه میگوییم. این روش برنامه نویسی کامپیوترها را مبتنی بر قوانین می نامند. در جایی که یادگیری ماشین با آن تفاوت دارد و جایگزین آن می شود، برنامه نویسی مبتنی بر قوانین این است که به تنهایی قادر به استنباط این قوانین است.

فرض کنید که یک مدیر بانک هستید و میخواهید بفهمید که آیا متقاضی وام احتمالاً وام خود را نکول میکند یا خیر. در یک رویکرد مبتنی بر قوانین، مدیر بانک (یا سایر کارشناسان) به صراحت به رایانه میگویند که اگر امتیاز اعتباری متقاضی کمتر از یک آستانه باشد، درخواست را رد کنید.

با این حال، یک الگوریتم یادگیری ماشینی به سادگی دادههای تاریخی مربوط به امتیازات اعتباری مشتریان و نتایج وام آنها را دریافت میکند و به خودی خود تعیین میکند که این آستانه چقدر باید باشد. با انجام این کار، دستگاه از دادههای تاریخی یاد میگیرد و قوانین خود را ایجاد میکند.

البته این فقط مقدمهای برای یادگیری ماشینی است، زیرا مدلهای یادگیری ماشین در دنیای واقعی معمولاً بسیار پیچیدهتر از یک آستانه ساده هستند. با این حال، این یک مثال عالی از قدرت یادگیری ماشینی است.

هر KPI سازمانی را می توان تا زمانی که داده های مربوطه را در اختیار داشت، بهینه کرد. برای مثال، با توجه به مجموعه دادههای مشتری تاریخی، میتوانید پیشبینی کنید که کدام یک از مشتریان فعلی شما در خطر ترک هستند، بنابراین میتوانید قبل از وقوع آن، این را متوقف کنید.

رویکردهای مدرن برای یادگیری ماشینی پیشرفت های بزرگی داشته اند و می توانند خیلی بیشتر از این کار را انجام دهند. الگوریتمهای یادگیری ماشینی، از ماشینهای خودران گرفته تا تشخیص صدا گرفته تا سیستمهای فیلتر خودکار ایمیلها که هرزنامهها را در صندوق ورودی شما علامتگذاری میکنند، اساس بسیاری از پیشرفتهای فناوری را تشکیل میدهند که امروزه به آن وابسته شدهایم.

در مرحله بعد، بیایید انواع مختلف الگوریتم های یادگیری ماشین و انواع خاصی از مسائل را که می توانند حل کنند، در نظر بگیریم.

انواع یادگیری ماشینی

الگوریتمهای یادگیری ماشین اغلب به سه دسته کلی تقسیم میشوند (اگرچه از طرحهای طبقهبندی دیگر نیز استفاده میشود): یادگیری تحت نظارت، یادگیری بدون نظارت و یادگیری تقویتی.

یادگیری تحت نظارت

یادگیری ماشینی نظارت شده به کلاسهایی از الگوریتمها اشاره دارد که در آن مدل یادگیری ماشین مجموعهای از دادهها با برچسبهای صریح برای کمیتی که به آن علاقهمندیم داده میشود (این کمیت اغلب به عنوان پاسخ یا هدف نامیده میشود).

یادگیری نیمه نظارت شده از ترکیبی از داده های برچسب دار و بدون برچسب برای آموزش مدل های هوش مصنوعی استفاده می کند.

اگر با داده های بدون برچسب سر و کار دارید، باید برچسب گذاری داده ها را انجام دهید. برچسبگذاری فرآیند حاشیهنویسی مثالهایی برای کمک به آموزش یک مدل یادگیری ماشینی است. برچسب زدن معمولا توسط انسان انجام می شود که می تواند گران و زمان بر باشد. با این حال، راههایی برای خودکار کردن فرآیند برچسبگذاری وجود دارد.

یک مثال عالی از یادگیری تحت نظارت، سناریوی درخواست وام است که قبلاً در نظر گرفتیم. در اینجا، ما دادههای تاریخی در مورد امتیازات اعتباری متقاضیان وام قبلی (و سطح درآمد احتمالی، سن و غیره) در کنار برچسبهای صریح داشتیم که به ما میگفتند آیا شخص مورد نظر در پرداخت وام خود نکول کرده است یا خیر.

الگوریتم های یادگیری تحت نظارت را می توان بیشتر به رگرسیون و طبقه بندی تقسیم کرد. این تفاوت به نوع کمیت مورد نظر ما اشاره دارد.

اگر هدف انتخابی بین چند دسته مجزا باشد – برای مثال، آیا متقاضی پیشفرض میشود یا نه، آیا این تصویر یک گربه، یک سگ، یا یک انسان و غیره است – آنگاه مشکل به عنوان طبقهبندی نامیده میشود. ما در حال تلاش برای تعیین کلاسی هستیم که یک نقطه داده معین به آن تعلق دارد.

با این حال، اگر متغیر هدف ما پیوسته باشد، مشکل به عنوان رگرسیون نامیده میشود. به عنوان مثال، پیش بینی قیمت یک خانه با توجه به تعداد اتاق خواب ها و موقعیت آن.

یادگیری بدون نظارت

در مسائل یادگیری بدون نظارت، دادههایی که به ما داده میشود فاقد برچسب هستند و ما صرفاً به دنبال الگوها هستیم. مثلاً بگویید آمازون هستید. با توجه به سابقه خرید مشتریان، آیا میتوانیم خوشههایی (گروههایی از مشتریان مشابه) را شناسایی کنیم؟

در این سناریو، حتی اگر دادههای صریح و قطعی در مورد علایق یک فرد نداریم، فقط شناسایی اینکه گروه خاصی از مشتریان اقلام مشابهی را خریداری میکنند میتواند به ما اجازه دهد تا توصیههای خرید را بر اساس آنچه دیگر افراد در خوشه نیز دارند ارائه دهیم. خریداری شده است. سیستمهای مشابه همان چیزی است که به چرخ فلک آمازون «شما هم علاقهمند باشید» است.

خوشهبندی K-means نوعی مدل خوشهبندی است که گروههای مختلف مشتریان را میگیرد و بر اساس شباهتهای موجود در الگوهای رفتاری آنها را به خوشهها یا گروههای مختلف اختصاص میدهد. در سطح فنی، با یافتن مرکز برای هر خوشه کار می کند، که سپس به عنوان میانگین اولیه برای خوشه استفاده می شود. سپس مشتریان جدید بر اساس شباهت آنها به دیگر اعضای آن خوشه به خوشه ها اختصاص داده می شوند.

علاوه بر این، هنگامی که خوشه ها را شناسایی کردیم، می توانیم ویژگی های آنها را مطالعه کنیم. به عنوان مثال، فرض کنید می بینیم که یک خوشه معین در حال خرید بازی های ویدیویی زیادی است. در آن صورت، میتوانیم حدس بزنیم که این گروه از مشتریان گیمر هستند، حتی اگر هیچکس واقعاً به ما این را نگفته باشد.

هنگامی که این شکل از تجزیه و تحلیل را انجام دادیم، حتی میتوانیم از برچسبهای یادگیری بدون نظارت برای ایجاد مدلهای یادگیری نظارتشده استفاده کنیم که به عنوان مثال، ممکن است به ما امکان پیشبینی مقدار پولی را که یک گیمر 25 ساله با آن خرج میکند، میدهد.

یادگیری تقویتی

یادگیری تقویتی کلاسی از الگوریتمهای یادگیری ماشین است که در آن ما یک عامل رایانه را برای انجام برخی کارها بدون ارائه راهنمایی زیادی به او در مورد اینکه دقیقاً چه کاری انجام دهد، اختصاص میدهیم.

در عوض، رایانه مجاز است انتخابهای خود را انجام دهد و بسته به اینکه این انتخابها به نتیجهای که میخواهیم منجر شود یا نه، جریمهها و پاداشهایی را تعیین میکنیم. ما این فرآیند را چندین بار تکرار میکنیم و به رایانه اجازه میدهیم روش بهینه انجام کاری را با آزمون و خطا و تکرارهای مکرر بیاموزد.

به این به عنوان رویکرد هویج و چوب برای یادگیری ماشین فکر کنید. تقریباً مثل این است که رایانه در حال انجام یک بازی ویدیویی است و کشف می کند که چه چیزی کار می کند و چه چیزی کار نمی کند.

جالب اینجاست که بازی کردن دقیقاً کاربردی است که در آن یادگیری تقویتی شگفتانگیزترین نتایج را نشان داده است. مدل بدنام AlphaGo گوگل، که حتی بالاترین رتبهبندی بازیکنان انسانی Go را شکست داد، با استفاده از یادگیری تقویتی ساخته شد.

گوگل از آن زمان همان فناوری را به AlphaZero، جانشین AlphaGo اصلی که به عنوان مرجع توسط شطرنج بازان برای تعیین بهترین استراتژی ها استفاده می شود، گسترش داده است.

یادگیری عمیق

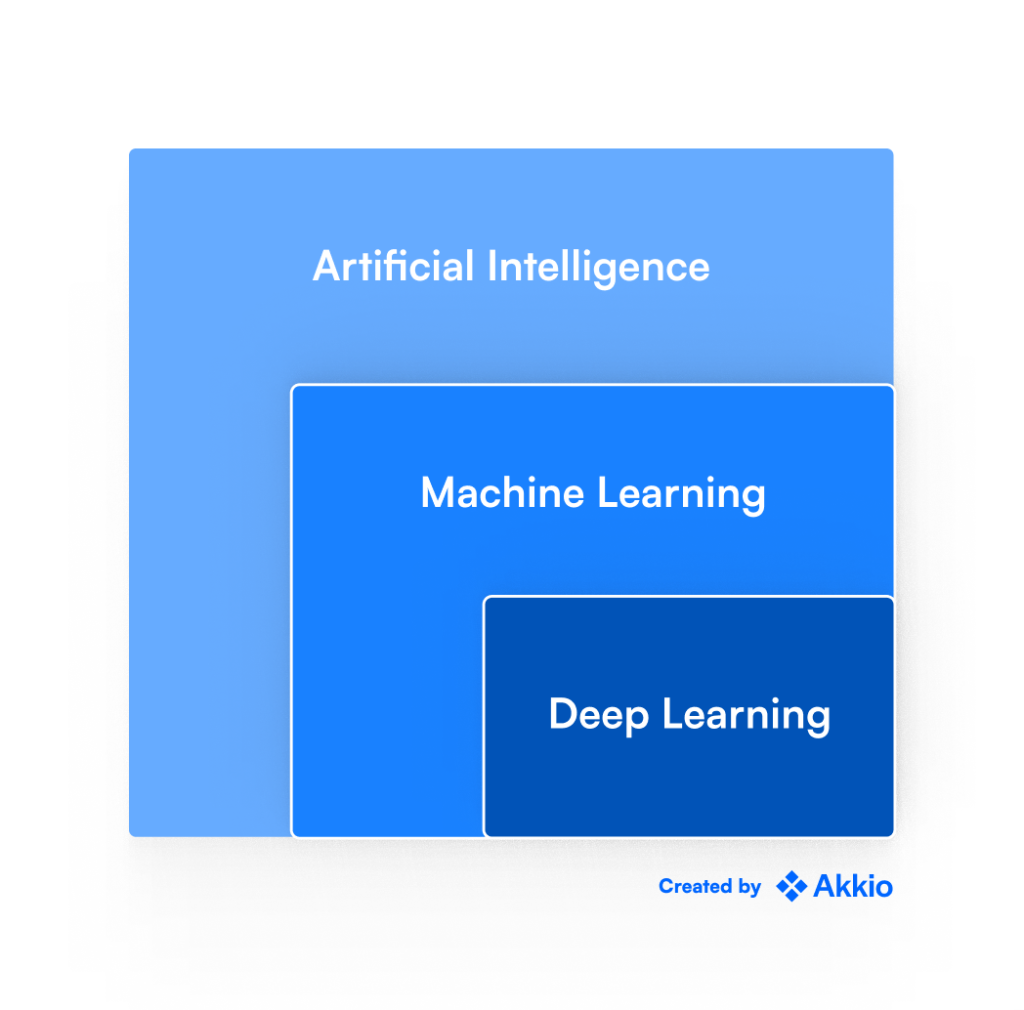

اگر یادگیری ماشینی را در اخبار دیده باشید، تقریباً مطمئناً در مورد یادگیری عمیق نیز شنیده اید. و ممکن است در این مرحله تعجب کنید که یادگیری عمیق در پارادایم فوق کجا قرار می گیرد.

و پاسخ همه آن ها است.

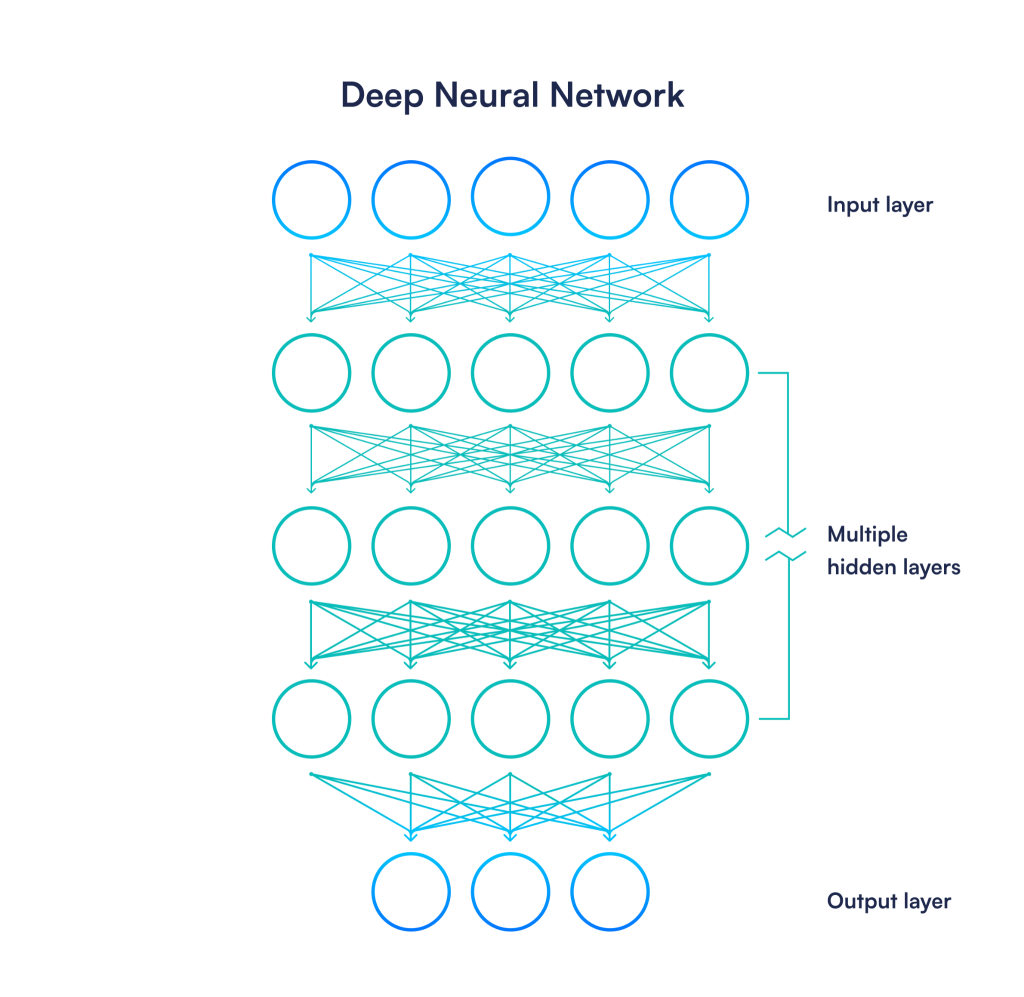

یادگیری عمیق زیرمجموعه ای از یادگیری ماشینی است که یک مشکل را به چندین “لایه” از “نورون ها” تقسیم می کند. این نورونها بر اساس نحوه عملکرد نورونها در مغز انسان بسیار ضعیف مدلسازی میشوند.

این کلاس از یادگیری ماشینی به عنوان یادگیری عمیق نامیده میشود، زیرا شبکه عصبی مصنوعی معمولی (مجموعه تمام لایههای نورونها) اغلب حاوی لایههای زیادی است.

در حالی که یادگیری عمیق در ابتدا برای مشکلات یادگیری تحت نظارت استفاده می شد، پیشرفت های اخیر قابلیت های آن را به مشکلات یادگیری بدون نظارت و تقویتی گسترش داده است.

و نتایج فوق العاده ای از خود نشان داده اند. بسیاری از آخرین پیشرفتها در بینایی کامپیوتر، که ماشینهای خودران و سیستمهای تشخیص چهره به آن وابسته هستند، ریشه در استفاده از مدلهای یادگیری عمیق دارند. پردازش زبان طبیعی، که به رایانهها اجازه میدهد مکالمات طبیعی انسان را درک کنند و سیری و دستیار گوگل را قدرتمند میکند، موفقیت خود را نیز مدیون یادگیری عمیق است.

رونق امروزی هوش مصنوعی عمدتاً به لطف پیشگامان یادگیری عمیق است: جفری هینتون، یان لیکان و یوشوا بنجیو. این مهندسان هوش مصنوعی به دلیل پیشرفت های چشمگیر خود در شبکه های عصبی عمیق، جایزه تورینگ را دریافت کردند.

تفاوت بین هوش مصنوعی و یادگیری ماشینی چیست؟

اگر تا به حال به وب سایت یک شرکت فناوری نگاه کرده باشید یا سخنرانی اصلی آخرین آیفون های اپل را تماشا کرده باشید، ممکن است عباراتی مانند هوش مصنوعی (AI) و یادگیری ماشین (ML) را دیده باشید که در همه جا ظاهر می شوند.

این کلمات اغلب به جای یکدیگر در نظر گرفته می شوند، اگرچه تفاوت های ظریف و مهمی بین آن ها وجود دارد. بنابراین، بیایید ببینیم که هر دوی این اصطلاحات دقیقاً چه معنایی دارند و چگونه همه آن ها با یکدیگر مرتبط هستند.

برای شروع، اجازه دهید ابتدا هر یک از این اصطلاحات را تعریف کنیم و سپس به این سوال که چگونه آن ها با هم مرتبط هستند، بپردازیم.

هوش مصنوعی چیست؟

در حالی که امکان نوشتن کتابی در زمینه هوش مصنوعی که علوم کامپیوتر، تاریخ، فلسفه و ماهیت هوش را پوشش می دهد، وجود دارد، اجازه دهید همه چیز را ساده نگه داریم. ساده ترین و در دسترس ترین راه برای تعریف هوش مصنوعی صرفاً نگاه کردن به کلمات است: این تلاشی برای ایجاد هوش است.

رشته هوش مصنوعی تئوری و عمل سیستم های هوشمند، به ویژه تصمیم گیری و یادگیری خودکار را مطالعه می کند.

به عبارت کمتر انتزاعی، این تلاشی است برای اجازه دادن به کامپیوترها برای تقلید از درک انسان از جهان و همچنین توانایی ما برای استدلال با آن.

البته این یک دستور بلند است، اما هدف نهایی تحقیقات هوش مصنوعی را به خوبی خلاصه می کند. ترمیناتور را در نظر بگیرید. این یک ماشین خیالی بود که کاملاً قادر بود جهان ما را هدایت کند، اطلاعات جدیدی را در مورد محیط اطراف خود و طبیعت بسیار پویای جهان و ساکنان آن ترکیب کند و بدون نیاز به هیچ دستورالعملی از سوی انسان تصمیمات مستقل بگیرد.

این تعریف همچنین کاملاً روشن می کند که ما با دستیابی به هوش مصنوعی واقعی فاصله بسیار زیادی داریم.

با این حال، سهم هوش مصنوعی امروزی تقریباً نامحدود است. مزایای هوش مصنوعی در حال حاضر در بسیاری از صنایع از جمله پزشکی، کشاورزی، تولید و یا صرفاً فروش و بازاریابی احساس می شود. هوش مصنوعی روش کار، بازی و تعامل ما با یکدیگر را تغییر میدهد، از ابزارهایی که استفاده میکنیم تا راههایی که با سازمانهایی که تشکیل میدهیم ارتباط برقرار میکنیم.

سه نوع هوش مصنوعی

اما در حالی که یک ماشین واقعاً مستقل که کاملاً قادر به مدیریت خود در همه موقعیتها است، جام مقدس تحقیقات در این زمینه است، ما قبلاً پیشرفت قابل توجهی در اجازه دادن به رایانهها برای نشان دادن توانایی انسانمانند هنگام انجام حداقل وظایف بسیار خاص داشتهایم.

برای تمایز بین این سطوح مختلف هوش، محققان در این زمینه اغلب هوش مصنوعی را به دو یا سه نوع تقسیم میکنند:

هوش مصنوعی باریک (ANI)

هوش عمومی مصنوعی (AGI)

ابر هوش مصنوعی (ASI)

ANI اغلب به عنوان هوش مصنوعی ضعیف شناخته می شود، زیرا برای نشان دادن «هوش» یا توانایی انسان مانند در انجام یک کار خاص طراحی شده است. یکی از مرزهای بعدی در ANI به حداکثر رساندن کارایی مدل ها است. این شامل بهینه سازی آموزش، استنتاج، و استقرار، و همچنین افزایش عملکرد هر یک است.

AGI یا هوش مصنوعی قوی به سیستمهایی اطلاق میشود که به طور کلی قادر به تطبیق هوش انسانی هستند (یعنی در بیش از چند کار خاص)، در حالی که یک ابر هوش مصنوعی میتواند از تواناییهای انسان پیشی بگیرد.

در حال حاضر، این مقایسهها عمدتاً به مکاتب فکری منتقل میشوند، زیرا همه مدلهای هوش مصنوعی مستقر نمونههایی از هوش مصنوعی باریک (نه AGI یا ASI) هستند.

تعدادی از عوامل هستند که ظهور AGI را تسریع می کنند، از جمله افزایش دسترسی به داده ها، توسعه الگوریتم های بهتر و پیشرفت در پردازش کامپیوتری.

هوش مصنوعی در فیلم “Her” نمونه ای فرهنگی از AGI است. سامانتا، شخصیت هوش مصنوعی فیلم، افکار و نظرات خاص خود را دارد. او یک ربات تابع نیست، بلکه یک موجود مستقل است. سامانتا قادر به استفاده از تشخیص صدا و گفتار، پردازش زبان طبیعی، بینایی کامپیوتری و غیره است.

این ها نمونههای خوبی از هوش مصنوعی باریک هستند، زیرا نشان میدهند که یک ماشین واقعاً یک کار را به خوبی انجام میدهد. با این حال، زیبایی هوش مصنوعی عمومی این است که میتواند همه این عناصر را در یک سیستم واحد و جامع ادغام کند که میتواند هر کاری را که یک انسان میتواند انجام دهد.

و در حالی که ما دومی را به دست نیاوردهایم، پیشرفت قابلتوجهی با اولی به دست آوردهایم. به عنوان مثال اتومبیل های خودران را در نظر بگیرید. آنها نمونه ای از ANI هستند، زیرا در یک کار خاص (ناوبری) برتری دارند و به طور کلی کاملاً قادر به شناسایی عناصر موجود در محیط خود (سایر خودروها، عابران پیاده و غیره) هستند و آن اطلاعات را در یک تصمیم ترکیب می کنند (به عنوان مثال، نحوه چرخش یا زمان استفاده از ترمز برای جلوگیری از برخورد).

دستیارهای مجازی مانند سیری و دستیار گوگل نمونه هایی از گام های بزرگی هستند که ما در ایجاد سیستم های ANI قوی که قادر به ایجاد ارزش واقعی برای مشاغل و افراد هستند، برداشته ایم.

این دستیارها از تشخیص گفتار استفاده میکنند، یک فناوری مجهز به هوش مصنوعی که به افراد اجازه میدهد دستورات صوتی را وارد کرده و پاسخ دریافت کنند. این از طریق یک مدل یادگیری ماشینی به دست می آید که ساختار زبان را با پردازش امواج صوتی می آموزد و درک می کند.

در هر سیستم هوش مصنوعی، داده ها برای پیش بینی جمع آوری و پردازش می شوند. سپس این داده ها پاک می شوند و به فرمتی تبدیل می شوند که می تواند توسط مدل استفاده شود. سپس مدل یک پیشبینی ایجاد میکند که میتواند به عنوان پاسخی به برخی ورودیها مشاهده شود. ورودی ممکن است یک سوال یا کار باشد و پاسخ را می توان یک پاسخ یا یک راه حل در نظر گرفت.

نمونههای دیگر عبارتند از سیستمهای تشخیص چهره و تصویر، گفتار به متن، ترجمه ماشینی (ترجمه گوگل) و موتورهای توصیه (چگونه آمازون یا نتفلیکس میدانند کدام محصول را میخواهید).

و این همان جایی است که یادگیری ماشین مطرح می شود، زیرا اکثر این پیشرفت ها به لطف یادگیری ماشینی (و یادگیری عمیق) امکان پذیر شده است.

چه AGI ظهور کند یا نه، هوش مصنوعی آینده در همه جا تعبیه خواهد شد و هر بخش از جامعه را تحت تأثیر قرار می دهد، از دستگاه های هوشمند گرفته تا برنامه های وام گرفته تا برنامه های تلفن. با رشد سریع هوش مصنوعی، عملاً همه صنایع در حال بررسی چگونگی استفاده از این فناوری جدید هستند.

یادگیری ماشینی چیست؟

همانطور که در مقدمه این راهنما بحث کردیم، “یادگیری ماشین شاخه ای از علوم کامپیوتر است که به کامپیوترها اجازه می دهد تا به طور خودکار الگوها را از داده ها استنتاج کنند بدون اینکه به صراحت گفته شود که این الگوها چیست.”

به این ترتیب، یادگیری ماشین یکی از راههای دستیابی ما به هوش مصنوعی است – یعنی سیستمهایی که قادر به تصمیمگیری مستقل و شبیه به انسان هستند. متأسفانه، این سیستمها تاکنون تنها به وظایف خاص محدود شدهاند و بنابراین نمونههایی از هوش مصنوعی محدود هستند.

در دو دهه گذشته، بسیاری از مهیجترین برنامههای یادگیری ماشینی از زیرمجموعهای از حوزهای که به آن یادگیری عمیق گفته میشود، آمدهاند. همانطور که در بخش یادگیری عمیق این راهنما مورد بحث قرار گرفت، الگوریتمهای یادگیری عمیق به عملکرد پیشرفتهای در تشخیص تصویر و مشکلات پردازش زبان طبیعی دست یافتهاند. آنها همچنین وعده های باورنکردنی در پیش بینی و تقویت مشکلات یادگیری نشان داده اند. بیایید به عقب برگردیم و به چگونگی ارتباط هوش مصنوعی، ML و DL با یکدیگر نگاه کنیم.

هوش مصنوعی و ML چگونه به هم مرتبط هستند؟

گرافیک زیر رابطه بین هوش مصنوعی، یادگیری ماشینی و یادگیری عمیق را به خوبی توضیح می دهد.

هوش مصنوعی کلیترین مورد از این سه مورد است و تقریباً میتوان آن را به عنوان هدف اصلی این حوزه تحقیقاتی در نظر گرفت: ایجاد سیستمهایی که قادر به تقلید از تصمیمگیری انسان هستند.

یک تصور غلط رایج این است که هوش مصنوعی در حال یادگیری است. در حقیقت، هوش مصنوعی توسط انسان ها برای تکمیل وظایف و ارائه پیش بینی ها برنامه ریزی شده است. هوش مصنوعی می تواند هوش را تقلید کند، اما نمی تواند به طور مستقل مانند یک شخص یاد بگیرد. هدف مهندسان هوش مصنوعی امروزه این است که ماشینها را بیشتر شبیه انسان و کمتر شبیه ماشینها بکنند.

یکی دیگر از اهداف امروزی محققان هوش مصنوعی این است که هوش مصنوعی رفتاری شبیه انسان داشته باشد. این امر به ویژه چالش برانگیز است، زیرا رفتار به عنوان محصول مشترک استعداد و محیط در نظر گرفته می شود که مفاهیم کاملاً متفاوتی بین افراد و ماشین ها هستند.

یادگیری ماشینی یکی از راههای دستیابی به هوش مصنوعی است، در حالی که یادگیری عمیق زیرمجموعهای از الگوریتمهای یادگیری ماشینی است که بیشترین امید را در برخورد با مشکلات مربوط به دادههای بدون ساختار، مانند تشخیص تصویر و زبان طبیعی نشان دادهاند.

یادگیری ماشین معمولاً به عنوان بخشی از سیستم های ترکیبی استفاده می شود. سیستمهای ترکیبی ترکیبی از هوش انسان و ماشین هستند که به دنبال ترکیب بهترینهای هر دو جهان هستند، مانند مدلهای یادگیری ماشینی که پیشبینیهایی را برای انسان ارسال میکنند تا تجزیه و تحلیل شوند.

مهم است که بین یادگیری ماشین و هوش مصنوعی تمایز قائل شویم، زیرا یادگیری ماشین تنها وسیلهای برای ایجاد سیستمهای هوشمند مصنوعی نیست – فقط موفقترین سیستمها تا کنون.

هوش مصنوعی نمادین

برای مثال، در سالهای اولیه تحقیق در این زمینه، محققان بر روی ساخت سیستمهای هوش مصنوعی نمادین متمرکز شدند – که به آن هوش مصنوعی کلاسیک یا هوش مصنوعی قدیمی (GOFAI) نیز گفته میشود.

این رویکرد برای ایجاد سیستم های هوشمند بر نمایش جهان به عنوان مجموعه ای از نمادها، ترجمه مسائل دنیای واقعی به گزاره های نمادین، و سپس اجازه دادن به کامپیوتر برای استفاده از منطق گزاره ای برای حل این مشکلات تمرکز دارد.

این تلاشها بر اساس مشاهده این بود که انسانها (و زبانهای ما) از نمادها برای نمایش هر دو شی در دنیای واقعی و نحوه ارتباط آنها با یکدیگر استفاده میکنند. “جان” و “پیتزا” نماد هستند، در حالی که “خوردن” رابطه بین این دو شی / نماد است.

فرض کنید میتوانیم کل جهان (یا حداقل، تمام اطلاعات مربوط به یک حوزه خاص، مانند پزشکی) را در چنین نمادها و روابطی نشان دهیم. در آن صورت، یک کامپیوتر می تواند این مشکلات را با استفاده از منطق حل کند.

همچنین میتوانیم گزارههای مختلف را با استفاده از قواعد if-then به هم پیوند دهیم. برای مثال، اگر گرسنه هستید (جان) پس بخورید (جان، پیتزا). این نمونه ای از یک هوش مصنوعی نمادین مبتنی بر قوانین بسیار ساده است.

البته، در حالی که این مثال ساده فقط از چند نماد و یک قانون استفاده می کند، یک سیستم کامپیوتری واقعی می تواند میلیاردها نماد، گزاره و قانون را ذخیره کند. چنین سیستمهای مبتنی بر قاعده پایه و اساس آنچه به عنوان سیستمهای خبره شناخته میشوند، ابزارهای هوش مصنوعی هستند که بر سلسله مراتبی از قوانین برای ارائه راهحل برای مشکلات تکیه دارند.

برای مثال، پزشک را در نظر بگیرید که بیمار را تشخیص می دهد. این تشخیص ها اغلب مبتنی بر قانون نیز هستند: به عنوان مثال، اگر بیمار علائم X و Y داشته باشد، اگر قند خون او بیشتر از Z باشد، پس به بیماری A مبتلا هستند. ، و پیشگیری محققان نشان داده اند که الگوریتم ها در طبقه بندی سلول ها به عنوان سرطانی یا غیر سرطانی بهتر از انسان هستند.

یا مشکل درخواست وام را در نظر بگیرید که در مقاله یادگیری ماشینی به آن پرداختیم. گروهی از کارشناسان به راحتی می توانند این مشکل را در یک سری نمادها و قوانین نشان دهند (به عنوان مثال، اگر امتیاز اعتباری > X و مبلغ وام < Y و سپس وام را تأیید کند). سپس میتوان از آن برای ایجاد یک سیستم خبره هوش مصنوعی استفاده کرد که به طور بالقوه میتواند جایگزین پزشک یا افسر وام برای تصمیمگیری شود.

هوش مصنوعی نمادین از چندین مزیت نسبت به یادگیری ماشینی برخوردار است. در حالی که سیستمهای یادگیری ماشین تشخیص الگو را بر روی دادههای تاریخی انجام میدهند، سیستمهای نمادین فقط به یک متخصص نیاز دارند تا فضای مشکل را بر اساس نمادها، گزارهها و قوانین تعریف کند. بنابراین، به هیچ داده آموزشی نیاز ندارد.

علاوه بر این، از آنجایی که سیستمهای هوش مصنوعی نمادین سلسله مراتبی از قوانین قابل خواندن برای انسان را تشکیل میدهند، تفسیر آنها بسیار سادهتر از مثلاً شبکههای عصبی عمیق هستند که بهطور معروف غیرشفاف هستند و تفسیر آنها دشوار است.

در نهایت، یک هوش مصنوعی نمادین ایدهآل، با تمام دانشی که یک انسان از جهان دارد، به طور بالقوه میتواند نمونهای از یک هوش مصنوعی عمومی (یا فوقالعاده) باشد که قادر به استدلال واقعی مانند یک انسان است.

با این گفته، در حالی که از لحاظ نظری منطقی است که استدلال کنیم که ما میتوانیم به طور بالقوه همه دانش را به عنوان نماد بیان کنیم، واقعیت این است که درک ما از جهان بهطور باورنکردنی پیچیده است و به صراحت تمام دانش بشری و عقل سلیم را به عنوان مجموعهای از نمادها و روابط بیان میکند. یک کار هرکولی خواهد بود.

نمایش برخی از اطلاعات به عنوان نماد نیز ممکن است دشوار باشد. به عنوان مثال، طبقه بندی تصاویر را در نظر بگیرید. چگونه می توان یک “2” را در شکل تصویر به عنوان یک نماد توصیف کرد؟ در حالی که شبکه های عصبی در این وظایف برتری دارند، ترجمه ساده مشکل به یک سیستم نمادین دشوار است.

این یکی از محدودیتهای اصلی تحقیقات نمادین هوش مصنوعی در دهههای 70 و 80 بود. این سیستم ها اغلب شکننده در نظر گرفته می شدند (یعنی قادر به رسیدگی به مشکلاتی که خارج از هنجار بودند)، فاقد عقل سلیم و در نتیجه راه حل های «اسباب بازی» بودند.

این محدودیتها یکی از محرکهای اولیه اولین «زمستان هوش مصنوعی» بودند، دورهای که اکثر بودجهها برای سیستمهای هوش مصنوعی برداشته شد، زیرا تحقیقات نتوانست به طور رضایتبخشی به این مشکلات رسیدگی کند.

در نتیجه، جدای از برخی کاربردهای خاص، هوش مصنوعی نمادین عموماً به نفع یادگیری ماشینی از مد افتاده است، که بر وظایف خاص (یعنی هوش مصنوعی باریک) تمرکز میکرد اما راهحلهای بسیار قویتری ارائه میکرد.

پیشرفتها در قدرت محاسباتی و تکثیر دادهها در عصر اینترنت نیز یک عامل تقویت کننده قابل توجه در فعال کردن سیستمهای یادگیری ماشینی بوده است، که عملکرد آنها اغلب به مقدار (و کیفیت) دادههای موجود محدود میشود.

با این حال، در سالهای اخیر، محققان شروع به ترکیب سیستمهای یادگیری ماشین، بهویژه شبکههای عصبی، با هوش مصنوعی نمادین کردهاند تا از نقاط قوت هر دو این رویکردها برای هوش مصنوعی استفاده کنند. این به عنوان محاسبات عصبی نمادین شناخته می شود.

کاربردهای ML: رگرسیون

بسیاری از برنامههای تجاری به پیشبینی یک مقدار پیوسته نیاز دارند. به عنوان مثال، “ارزش مادام العمر یک مشتری با سن و سطح درآمد معین چقدر است؟”، یا “احتمال ریزش مشتری چقدر است؟” اینها معمولاً به عنوان مشکلات رگرسیون نامیده می شوند.

در این مقاله، چندین الگوریتم یادگیری ماشینی را که برای حل مسائل رگرسیون استفاده میشوند، مرور خواهیم کرد. در حالی که ما ریاضیات را به طور عمیق پوشش نمی دهیم، حداقل به طور خلاصه به شکل کلی ریاضی این مدل ها می پردازیم تا درک بهتری از شهود پشت این مدل ها به شما ارائه دهیم.

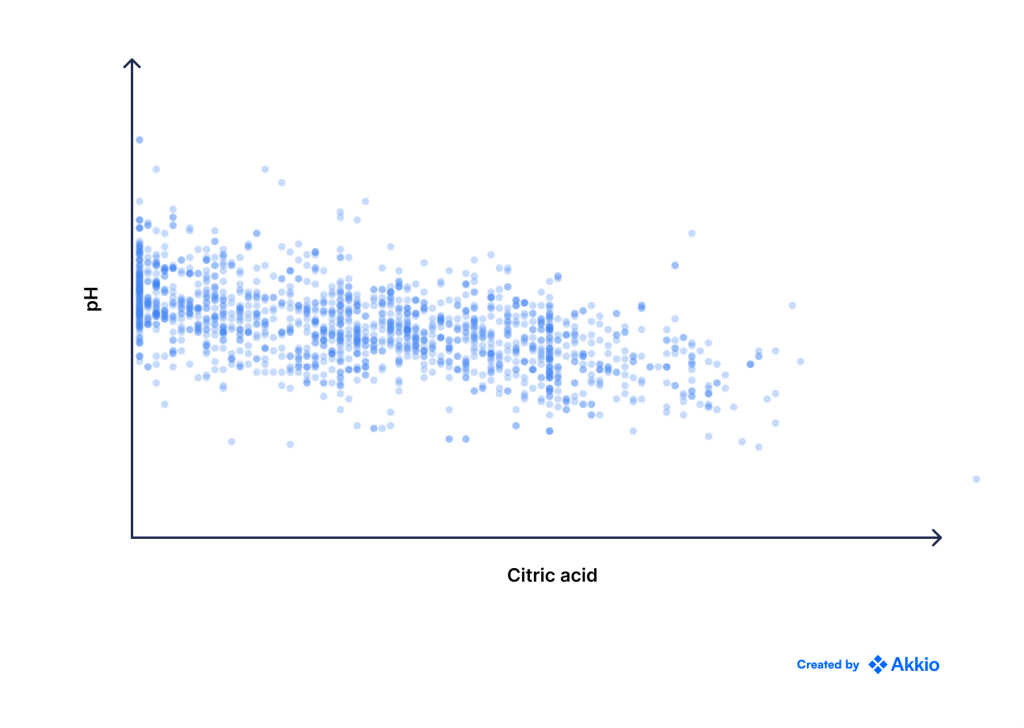

رگرسیون خطی

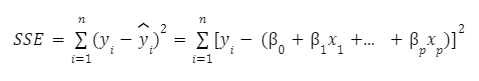

رایج ترین روش برای حل مسائل رگرسیون به عنوان رگرسیون خطی شناخته می شود. فرض کنید اطلاعات زیر در مورد رابطه بین pH و اسید سیتریک برای تعیین کیفیت شراب به شما داده شده است.

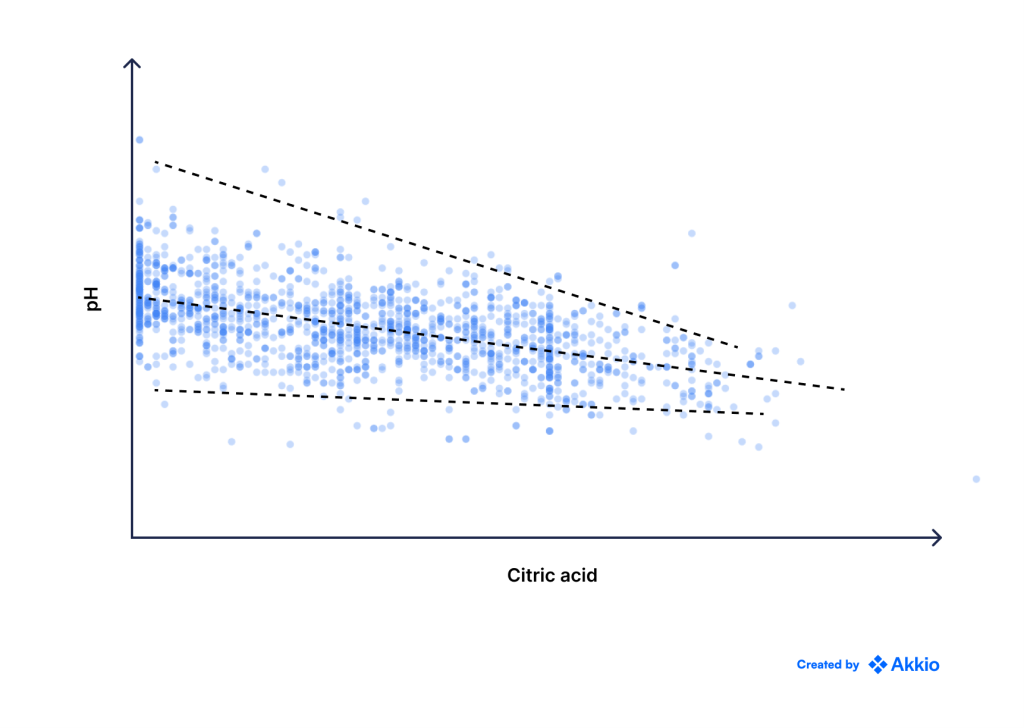

شما می توانید به وضوح یک رابطه خطی بین این دو مشاهده کنید، اما مانند تمام داده های واقعی، مقداری نویز نیز وجود دارد. از آنجایی که رابطه خطی است، مدل سازی آن با استفاده از یک خط مستقیم منطقی است.

ممکن است از ریاضی دبیرستان به یاد بیاورید که معادله یک خط مستقیم به صورت زیر است:

جایی که

![]()

y پاسخ است،

x پیش بینی کننده است،

m شیب خط (یا ضریب/وزن x) است و

c وقفه y است،

میتوانیم این را به پیشبینیکنندههای چندگانه به صورت زیر تعمیم دهیم، که شکل کلی رگرسیون خطی نیز است:

جایی که

![]()

y^ پیشبینی مدل ما است

β₀ وقفه است

βᵢ ضریب پیش بینی xᵢ-امین است و

p تعداد کل پیشبینیکنندهها است

اما به طور بالقوه میتوانیم خطوط مستقیم زیادی ترسیم کنیم و به دلیل نویز، کاملاً مشخص نیست که کدام یک «بهترین خط» است. مثلا از بین سه خط زیر کدام یک بهتر است؟

این امر مستلزم آن است که معیاری برای آنچه که از نظر ریاضی «خوب» در مقابل «بد» در نظر گرفته میشود، تعریف کنیم.

از آنجایی که ما از این مدل برای پیشبینی مقادیر استفاده میکنیم، منطقی است که از خطای پیشبینیهایمان به عنوان معیار خود استفاده کنیم، جایی که خطا به عنوان تفاوت بین مقدار واقعی و پیشبینی ما تعریف میشود. خطی که خطای پیشبینی کلی را به حداقل میرساند «خوب» است، در حالی که خطی که خطای کلی بزرگی دارد «بد» است.

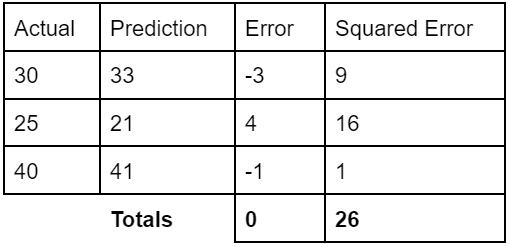

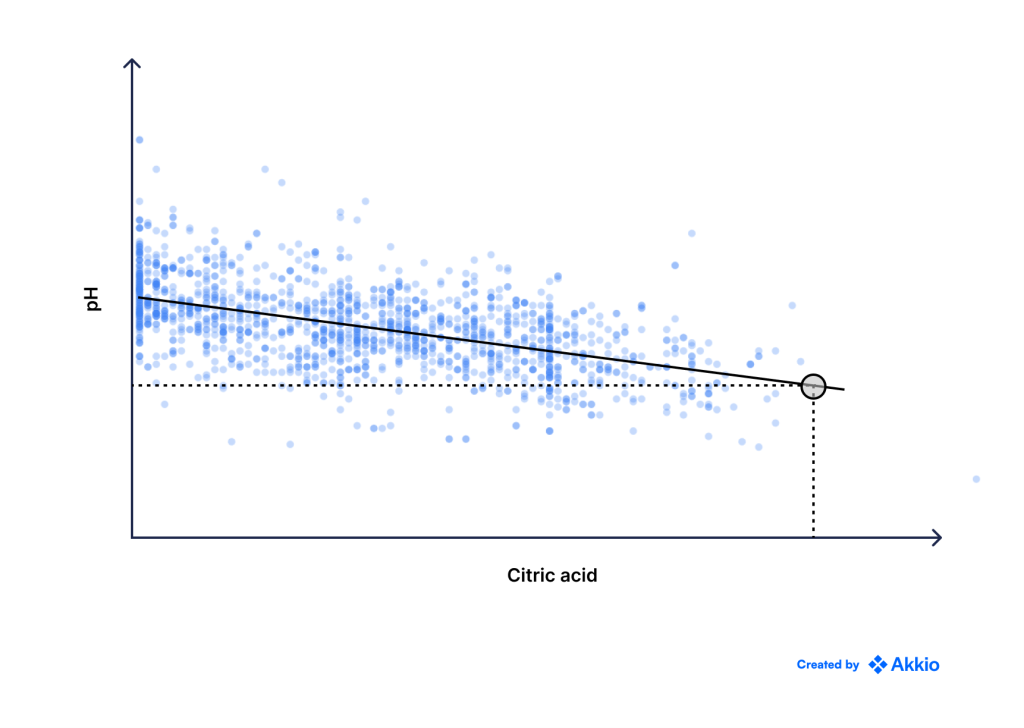

روش های مختلفی برای محاسبه خطاها وجود دارد. برای اهداف خود، از مجموع مربعات خطاها (SSE) استفاده خواهیم کرد. به عنوان یک مثال ساده از این موضوع، مثال زیر را برای پیش بینی آب و هوا در نظر بگیرید:

در این مرحله، ممکن است تعجب کنید که چرا ما مربع خطاها را در نظر می گیریم، و نه فقط مقدار واقعی را. این به این دلیل است که ما نمی خواهیم خطاهای منفی و مثبت یکدیگر را خنثی کنند.

اگر فقط مقادیر خطا را در مثال بالا جمع کنیم، 4 – 3 – 1 = 0 به دست میآوریم. این نشان میدهد که مدل بینقص است و به ما حس اعتماد کاذب نسبت به مدلمان میدهد. استفاده از خطاهای مربعی از این اتفاق جلوگیری می کند.

فرمول ریاضی زیر مجموع مجذور خطاهای فوق الذکر را توصیف می کند. هنگام استفاده از مجموع مربعات خطاها، درک این نکته مهم است که این نشانگر کاملی نیست که یک مدل چقدر با داده ها مطابقت دارد، اما درک آن ساده است، و بنابراین به طور گسترده استفاده می شود، زیرا فقط بر سه مقدار متکی است: عدد. از نقاط داده، مقادیر واقعی و پیش بینی ها.

جایی که

n تعداد نقاط داده ای که داریم

yᵢ مقدار واقعی پاسخ برای نقطه داده i است

yᵢ پیشبینی ما برای نقطه داده i است

بنابراین، از بین تمام خطوط ممکنی که می توانیم ترسیم کنیم، خطی را با کمترین SSE انتخاب می کنیم. به این تابع هدف می گویند—یعنی مقداری که می خواهیم کمینه یا حداکثر کنیم. در این مورد، ما می خواهیم SSE را به حداقل برسانیم.

در حالی که در اینجا وارد جزئیات ریاضی نمیشویم، این مشکل را میتوان به راحتی با استفاده از نظریه بهینهسازی حل کرد، بنابراین به ما امکان میدهد «بهترین» خط را پیدا کنیم که مجموع مربعات خطاها را به حداقل میرساند.

هنگامی که بهترین خط را پیدا کردیم، میتوانیم هر نقطه ورودی جدید را با درون یابی مقدار آن از خط مستقیم پیشبینی کنیم. برای مثال، در حالی که هیچ یک از نقاط داده ما اسید سیتریک 0.8 ندارند، میتوانیم پیشبینی کنیم که وقتی مقدار اسید سیتریک 0.8 است، pH ~3 است.

در حالی که مثال بالا با تنها یک پاسخ و یک پیشبینی کننده بسیار ساده بود، ما به راحتی میتوانیم همان منطق را به مسائل پیچیدهتر شامل ابعاد بالاتر (یعنی پیشبینیکنندههای بیشتر) تعمیم دهیم.

روشهای رگرسیون غیرخطی

مشکلات رگرسیون در دنیای واقعی اغلب غیرخطی هستند. راه های زیادی برای مقابله با چنین مشکلاتی وجود دارد، چه با گسترش خود مدل رگرسیون خطی یا با استفاده از ساختارهای مدل سازی دیگر.

به عنوان مثال، می گوییم داده هایی که داریم به این صورت است:

در حالی که مقداری نویز وجود دارد، می توانید ببینید که این یک منحنی درجه دوم است. بیایید بگوییم می دانیم که رابطه واقعی با معادله به دست می آید:

![]()

ما به راحتی میتوانیم مدل رگرسیون خطی را به سادگی با گرفتن مربع متغیر وابسته و اضافه کردن آن به عنوان پیشبینیکننده دیگری برای مدل رگرسیون خطی به این مسئله بسط دهیم. ما میتوانیم همین کار را برای عبارتهای مرتبه بالاتر انجام دهیم، و به آن رگرسیون چند جملهای گفته میشود.

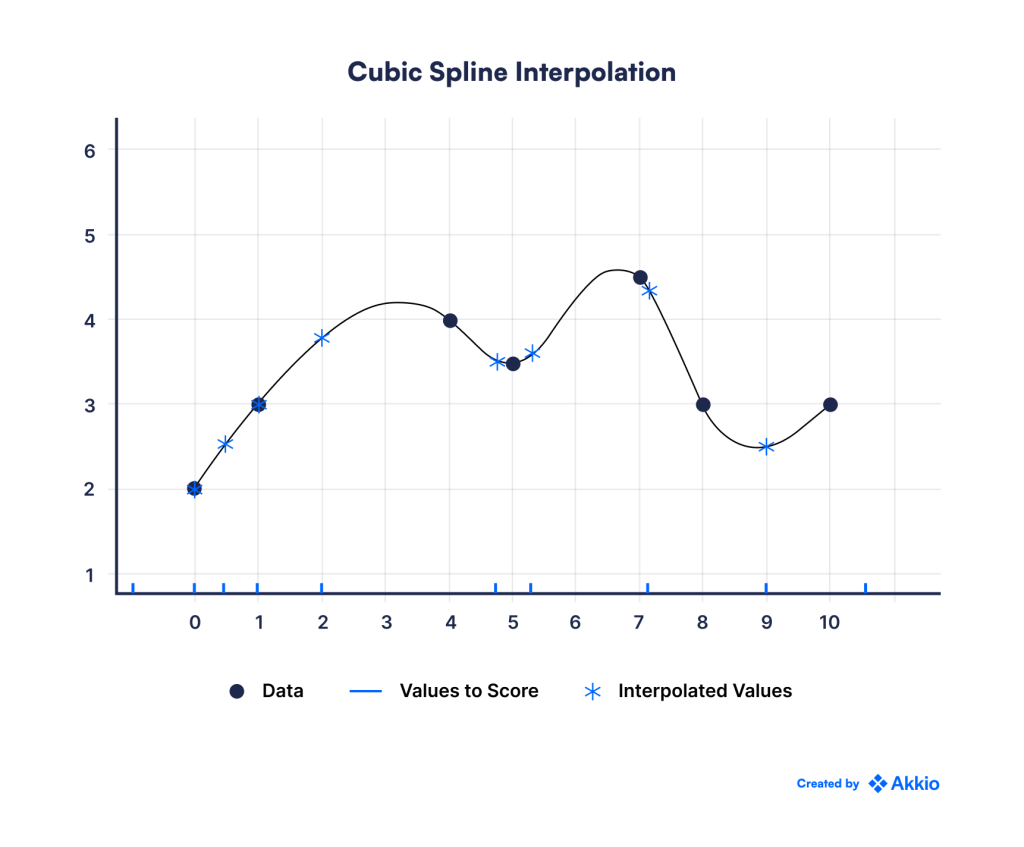

سایر روشهای پیچیدهتر شامل استفاده از اسپلاین است. در حالی که ما با جزئیات وارد نظریه یا ریاضیات پشت این موضوع نمیشویم، در یک سطح بنیادی، spline به ما اجازه میدهد تا توابع غیرخطی مختلف را در قسمتهای مختلف فضای ورودی قرار دهیم، در حالی که از صاف بودن توابع اطمینان حاصل میکنیم (یعنی متصل هستند). ) در مرزهای بین این مناطق.

نتیجه یک مدل بسیار انعطافپذیر است که میتواند دادههای غیرخطی را نزدیکتر جا دهد. با این حال، این ممکن است به قیمت تطبیق بیش از حد باشد، زیرا ممکن است مدل به جای الگوهای واقعی با نویز تصادفی مطابقت داشته باشد. در نتیجه، خطوط و رگرسیون چند جملهای باید با دقت مورد استفاده قرار گیرند و با استفاده از اعتبارسنجی متقاطع ارزیابی شوند تا اطمینان حاصل شود که مدلی که آموزش میدهیم میتواند تعمیم یابد.

همچنین ممکن است از روشهای ناپارامتریک برای مشکلات رگرسیون استفاده کنیم. سادهترین آنها ممکن است فقط رگرسیون K-نزدیکترین همسایه باشد. در این روش، با توجه به دادههای تاریخی و نقطه داده جدیدی که میخواهیم برای آن پیشبینی کنیم، به سادگی نزدیکترین نقاط داده k به این نقطه جدید را پیدا میکنیم و مقدار آن را میانگین این نقاط k پیشبینی میکنیم.

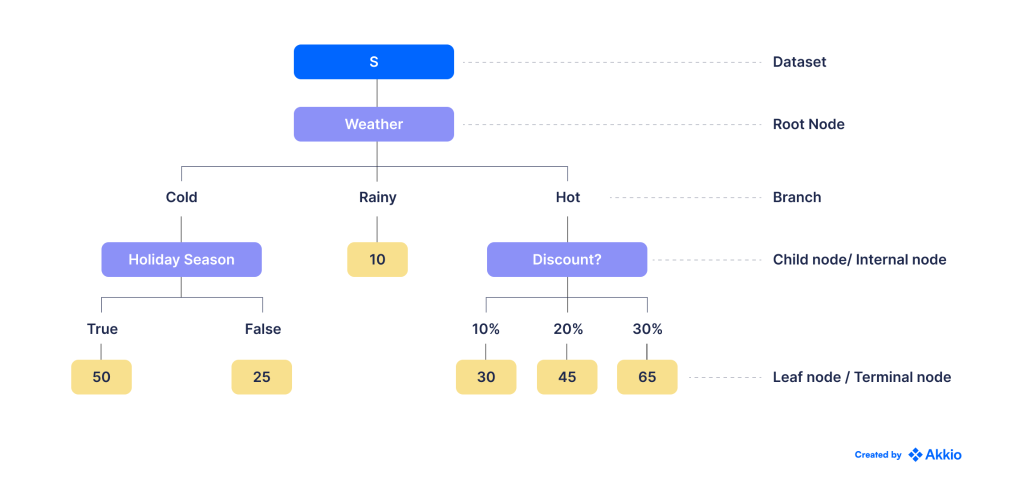

همچنین میتوانیم از درختهای تصمیم برای مشکلات رگرسیون استفاده کنیم. در اینجا، ما داده ها را بر اساس مجموعه ای از معیارها به زیر مجموعه های مختلف تقسیم می کنیم. سپس ممکن است یک مقدار ثابت به هر گره برگ به عنوان پیش بینی آن اختصاص دهیم (مثلاً میانگین تمام نقاط داده متعلق به آن گره برگ). مثال زیر را در مورد استفاده از رگرسیون درخت تصمیم برای پیشبینی تعداد ساعتهای بازی بر اساس شرایط آب و هوایی مختلف ببینید:

روش دیگر، ما همچنین میتوانیم یک مدل رگرسیون خطی جداگانه برای هر یک از گرههای برگ قرار دهیم.

مانند بسیاری دیگر از مشکلات یادگیری ماشین، ما همچنین میتوانیم از یادگیری عمیق و شبکههای عصبی برای حل مسائل رگرسیون غیرخطی استفاده کنیم.

پیش بینی احتمالات با رگرسیون لجستیک

بیایید ایده پیش بینی یک متغیر پیوسته را به احتمالات گسترش دهیم. فرض کنید میخواستیم احتمال لغو اشتراک مشتری در سرویس ما را پیشبینی کنیم.

از آنجایی که احتمال یک متغیر پیوسته است، به طور طبیعی خود را به رگرسیون گسترش می دهد. با این حال، این یک متغیر پیوسته است که توسط دو قید محدود شده است: یک احتمال نه میتواند منفی باشد و نه بیشتر از 1. رگرسیون خطی منظم قادر به رعایت این محدودیتها نیست، و بنابراین مدل لجستیک متولد شد.

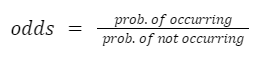

رگرسیون لجستیک گسترش رگرسیون خطی است که خط بین رگرسیون و طبقه بندی را در بر می گیرد. بر اساس همان اصل رگرسیون خطی کار میکند، اما با یک تفاوت کلیدی: پاسخ، گزارش طبیعی احتمال وقوع یک رویداد است.

شانس، در آمار، به نسبت احتمال وقوع یک رویداد به احتمال رخ ندادن آن اشاره دارد:

به عنوان مثال، می گویند احتمال پیروزی بارسلونا در بازی بعدی خود 30٪ است. سپس، شانس پیروزی آنها 3/7 یا 3:7 است. این نامگذاری نیز در قمار مورد استفاده قرار میگیرد، اگرچه سایتهای قمار اغلب شانسهایی را در برابر یک رویداد نشان میدهند و نه شانسی برای آن. شانس مقابل بارسلونا در این مورد 7:3 خواهد بود.

گزارش شانس (یا log-odds) اغلب به عنوان logit(p) نامیده میشود، جایی که p احتمال وقوع یک رویداد است. بنابراین مدل لجستیک با معادله زیر نشان داده می شود:

![]()

از نظر آماری، برجستهترین جنبه استفاده از لاگ طبیعی شانس این است که در حالی که خروجی مدل رگرسیون هنوز محدود نشده است، وقتی شانسهای ورود به سیستم را به احتمالات برمیگردانیم، این احتمالات بین 0 تا 1 محدود میشوند، بنابراین مشکل ما حل میشود!

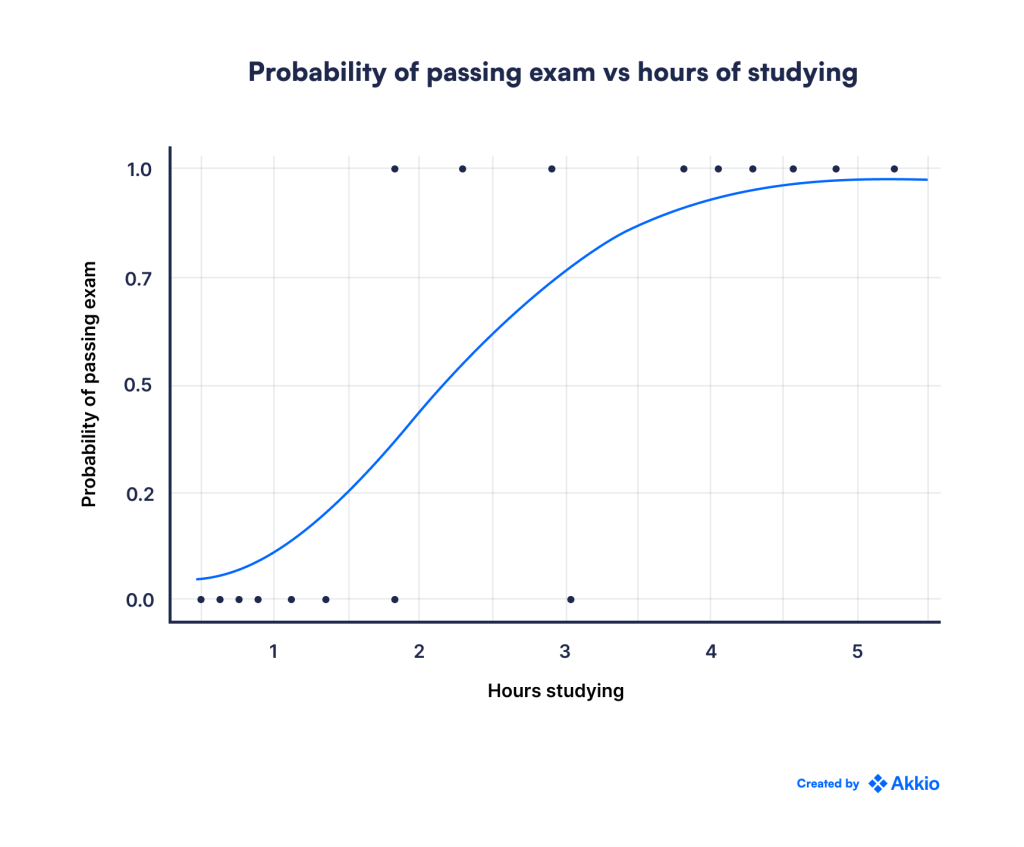

در حالی که ما وارد جزئیات ریاضی نمیشویم، اما میتوانید نموداری از احتمال خروجی p را در زیر مشاهده کنید که مقدار متغیر مستقل تغییر میکند:

بنابراین، ما با موفقیت مدل رگرسیون خطی را برای پیشبینی احتمالات گسترش دادیم. زمانی که تخمینی برای احتمال وقوع یک رویداد داشته باشیم، طبقهبندی فقط یک قدم با شما فاصله دارد.

اگر احتمال خاصی را به عنوان آستانه تعیین کنیم، میتوانیم هر نقطه داده (به عنوان مثال، هر مشتری) را به یکی از دو کلاس طبقهبندی کنیم. انتخاب این آستانه تا حد زیادی به برنامه بستگی دارد.

به عنوان مثال، یک خودروساز لوکس که با حاشیه های بالا و حجم پایین کار می کند، ممکن است بخواهد بسیار فعال باشد و شخصاً با احتمال 20 درصد از کار افتادن مشتریان خود را بررسی کند. اگر انحراف از نظر مأموریت حیاتی نیست یا ما به سادگی منابع لازم برای رسیدگی به مشتریان فردی را نداریم، ممکن است بخواهیم این آستانه را بسیار بالاتر (مثلاً 90٪) تعیین کنیم، بنابراین فقط در مورد فوری ترین مشتریان بالقوه هشدار داده می شود.

کاربردهای ML: طبقه بندی

در بخش قبل، به نمونههایی از مشکلات رگرسیون پرداختیم، جایی که میخواهیم یک متغیر پیوسته را پیشبینی کنیم. دومین نوع مشکل یادگیری تحت نظارت، طبقهبندی است، جایی که میخواهیم هر نمونه را به یکی از دو (یا بیشتر) دستهبندی کنیم.

به عنوان مثال، یک بانک ممکن است بخواهد تعیین کند که آیا متقاضی وام وام خود را بازپرداخت می کند یا خیر. یا ممکن است یک ارائه دهنده ایمیل بخواهد سیستمی بسازد که هرزنامه را از صندوق ورودی شما فیلتر کند.

در هر دوی این موارد، ما فقط دو کلاس/دسته ممکن داریم، اما امکان رسیدگی به مشکلات با چندین گزینه نیز وجود دارد. برای مثال، یک سیستم امتیازدهی سرنخ ممکن است بخواهد بین لیدهای گرم، خنثی و سرد تمایز قائل شود. مشکلات بینایی رایانه اغلب مشکلات چند طبقه ای نیز هستند، زیرا ما می خواهیم چندین نوع اشیاء (ماشین ها، افراد، علائم راهنمایی و رانندگی و غیره) را شناسایی کنیم.

در این مقاله، برخی از الگوریتمهای مورد استفاده برای مسائل طبقهبندی را بررسی میکنیم. با این حال، تمرکز در اینجا بر ایجاد شهود خواهد بود، و بنابراین ما ریاضیات پشت این الگوریتمها را با جزئیات پوشش نمیدهیم. ما همچنین برای سادگی فقط بر روی مشکلات طبقه بندی باینری (یعنی مواردی که فقط دو گزینه دارند) تمرکز خواهیم کرد.

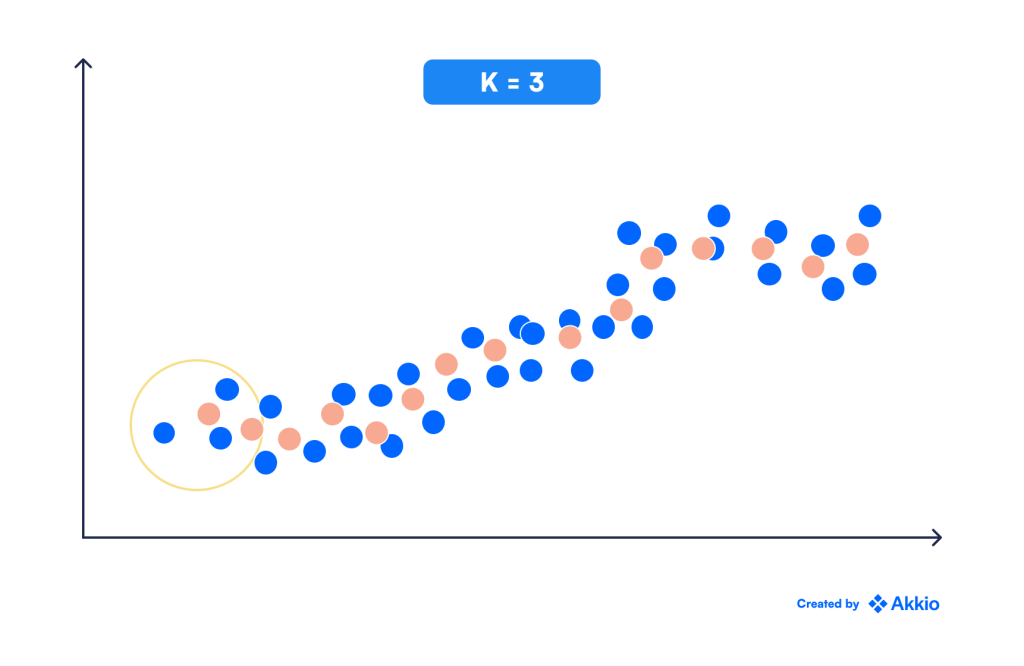

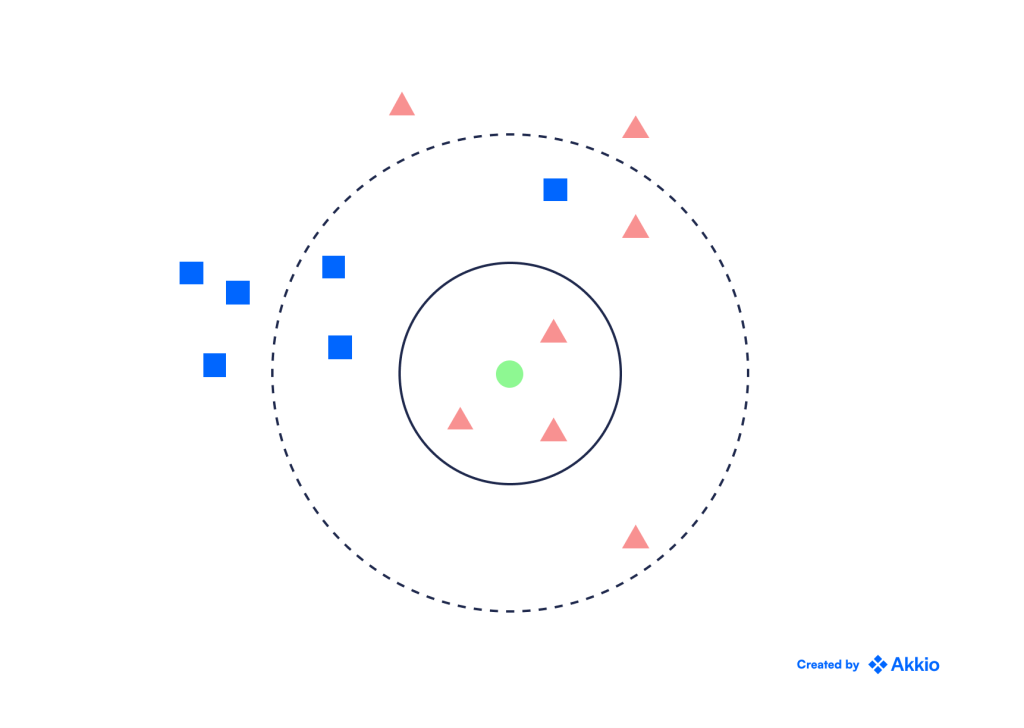

K-Nearest Neighbours (KNN)

یکی از سادهترین الگوریتمهای طبقهبندی، طبقهبندی KNN است. فرض کنید ما داده های تاریخی با برچسب ها و یک نقطه جدید داریم که می خواهیم برچسب آن را تعیین کنیم. در این روش، ما به سادگی نزدیکترین نقطه k به نقطه جدید را پیدا میکنیم و برچسب آن را به عنوان حالت (متداولترین کلاس) این نقاط k اختصاص میدهیم.

برای مثال، تصویر زیر را در نظر بگیرید. اگر k=3، برچسب نقطه سبز یک مثلث قرمز است زیرا در بین سه نقطه نزدیک به آن، اکثریت (⅔) مثلث های قرمز هستند.

همانطور که در بخش رگرسیون بحث کردیم، الگوریتم KNN میتواند مسائل رگرسیون غیرخطی را نیز حل کند.

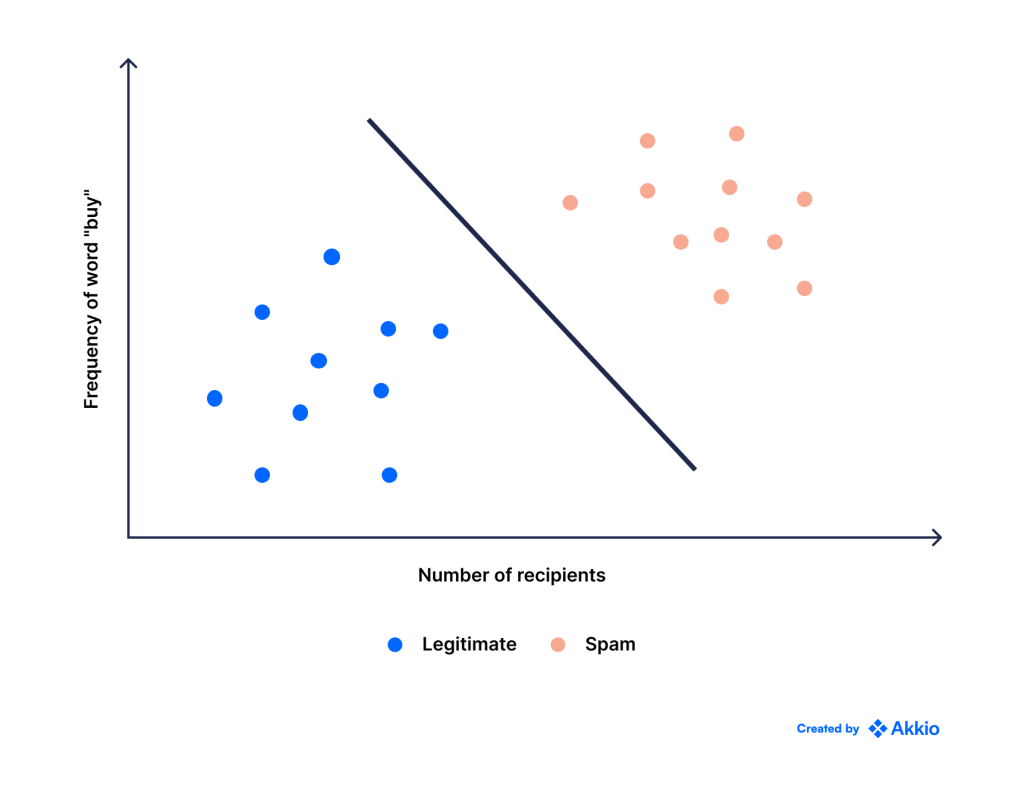

ماشینهای بردار پشتیبانی (SVM)

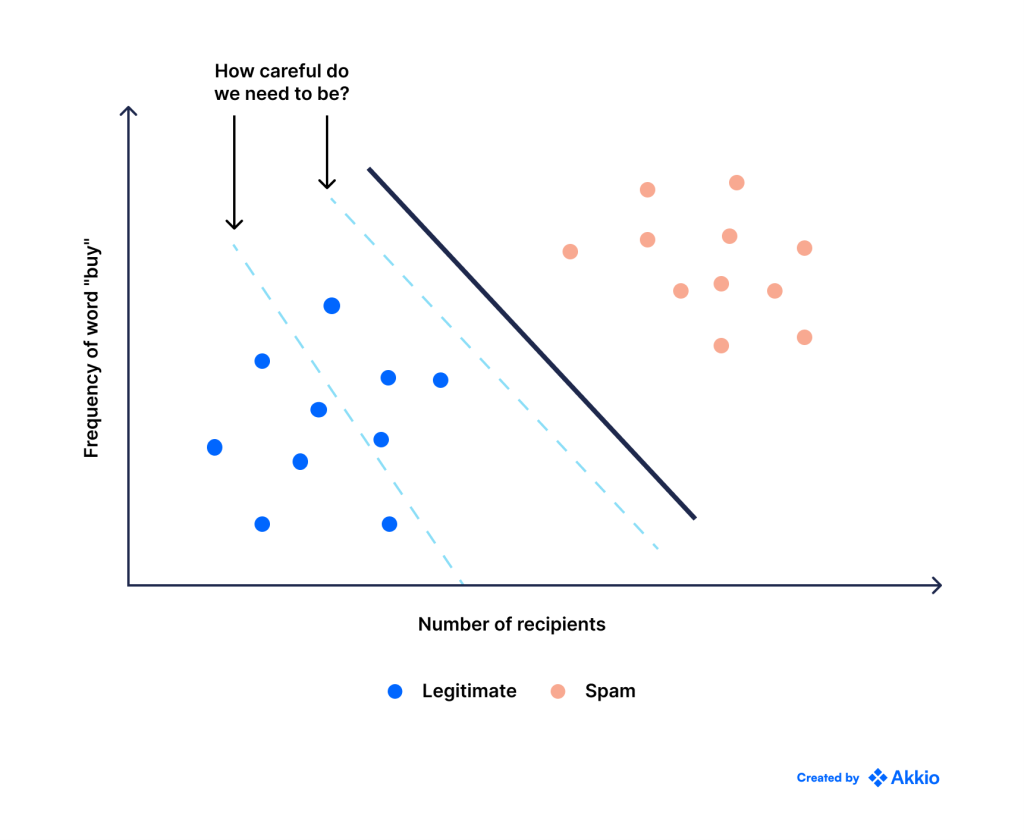

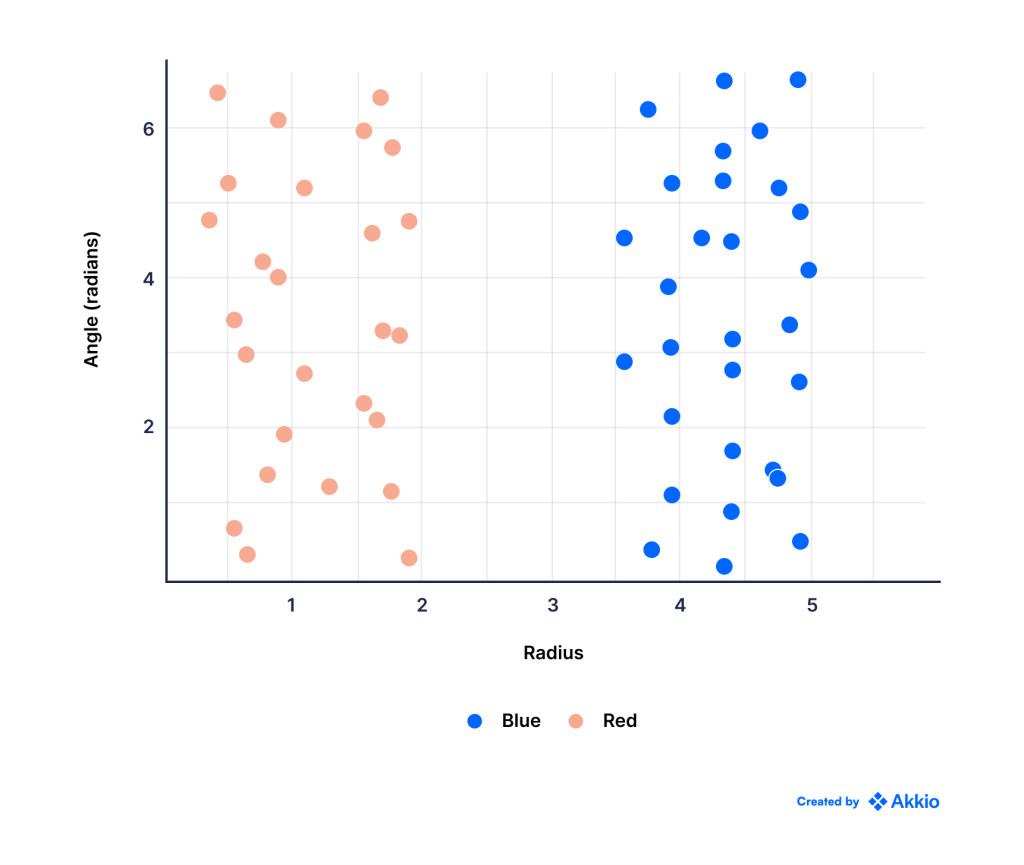

یکی دیگر از الگوریتم های طبقه بندی رایج SVM است. مثال زیر را در نظر بگیرید که در آن می خواهیم ایمیل های اسپم را فیلتر کنیم. محور x تعداد دفعاتی است که کلمه خرید در ایمیل ظاهر می شود و محور y تعداد افرادی است که همان ایمیل را دریافت کرده اند. هنگامی که رسم می شود، داده ها به شکل زیر هستند:

نقاط آبی ایمیل های قانونی هستند و نقاط قرمز اسپم هستند. ایمیلهای اسپم احتمالاً از شما میخواهند چیزهایی بخرید و برای افراد بیشتری ارسال میشوند، بنابراین منطقی است که ایمیلهایی که برای تعداد زیادی از افراد ارسال میشوند با ذکر کلمه «خرید» زیاد، هرزنامه باشند.

مهمتر از همه، ما می بینیم که می توانیم به وضوح این دو کلاس را با استفاده از یک خط مستقیم از هم جدا کنیم، اما مانند رگرسیون خطی، این سوال ایجاد می کند: کدام خط بهترین است؟

همانطور که در زیر نشان داده شده است، می توانیم خطوط ممکن زیادی را ترسیم کنیم که همه آنها کاملاً بین دو کلاس از هم جدا می شوند.

بنابراین، ممکن است بخواهیم به این فکر کنیم که چه چیزی یک خط را بهتر از خط دیگر می کند. این تا حدودی به مشکلی که ما در تلاش برای حل آن هستیم بستگی دارد و بعداً به این نکته خواهیم پرداخت.

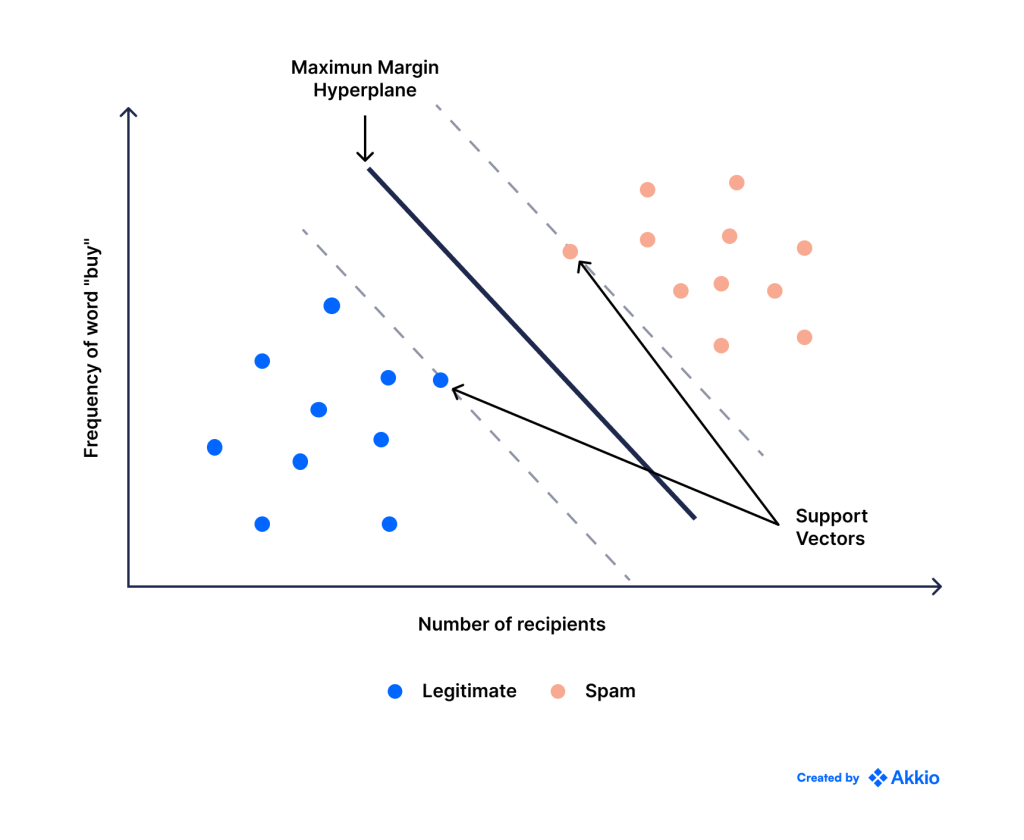

با این حال، در حال حاضر، یک معیار معقول ممکن است انتخاب خطی باشد که حاشیه بین دو کلاس را به حداکثر میرساند – یعنی خطی که تا حد امکان از افراطیترین نمونههای هر کلاس دور باشد.

این سؤال دیگری را ایجاد می کند: چگونه می توانیم این را به جای اینکه آن را با چشم انجام دهیم به یک مسئله ریاضی تبدیل کنیم؟ نمودار زیر را در نظر بگیرید.

میتوانیم «بهترین» خط را با ترسیم دو خط که فقط بیرونیترین نقاط هر کلاس را لمس میکنند، پیدا کنیم. همچنین توجه داشته باشید که هر دوی این خطوط موازی یکدیگر هستند. این خطوط بردارهای پشتیبانی نامیده می شوند. از این رو نام الگوریتم است.

سپس خط “بهترین” خطی است که با هر دوی این خطوط موازی است و همچنین از آنها فاصله دارد (یعنی فاصله آن از هر یک برابر است). فاصله بین بردارهای پشتیبان و خط طبقهبندیکننده حاشیه نامیده میشود و ما میخواهیم این را به حداکثر برسانیم.

این رایج ترین (یا پیش فرض) روشی است که در آن SVM بهترین خط طبقه بندی کننده را انتخاب می کند. با این حال، ممکن است همیشه این روش ایده آل برای انجام کارها نباشد.

به عنوان مثال، فرض کنید ما در حال کار بر روی تعیین خوش خیم یا بدخیم بودن تومور بودیم. در این صورت هزینه اشتباه برای هر کلاس یکسان نیست. اگر یک تومور بدخیم را به عنوان خوش خیم طبقه بندی کنیم، ممکن است به قیمت جان بیمار تمام شود، در حالی که اشتباه گرفتن یک تومور خوش خیم به عنوان بدخیم ممکن است فقط به آزمایش های بیشتر نیاز داشته باشد. واضح است که یک اشتباه از دیگری بدتر است.

بسته به کاربرد و میزان دقتی که میخواهیم انجام دهیم، ممکن است وزن بیشتری را به هر یک از انواع اشتباه اختصاص دهیم. به این ترتیب، ممکن است تصمیم بگیریم خط را از یک کلاس دورتر کنیم یا حتی عمداً برخی از نقاط داده را به اشتباه برچسب گذاری کنیم، فقط به این دلیل که می خواهیم در مورد اشتباه بسیار محتاط باشیم.

در مرحله بعد، بیایید سناریوهایی را در نظر بگیریم که در آن دو کلاس نمی توانند به طور تمیز از طریق یک خط مستقیم از هم جدا شوند.

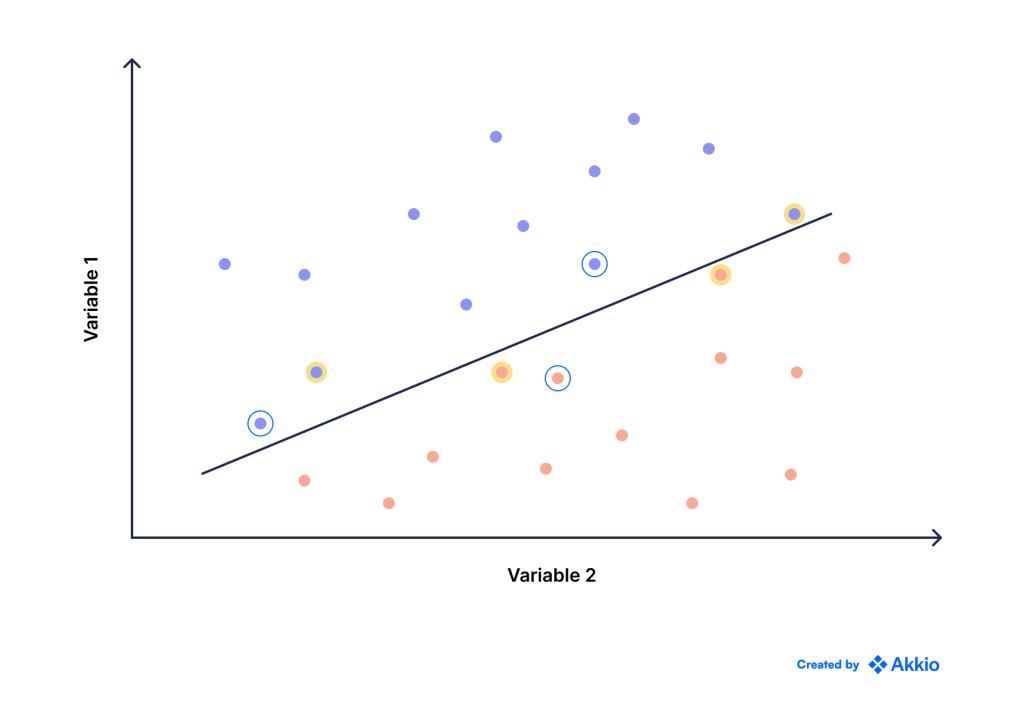

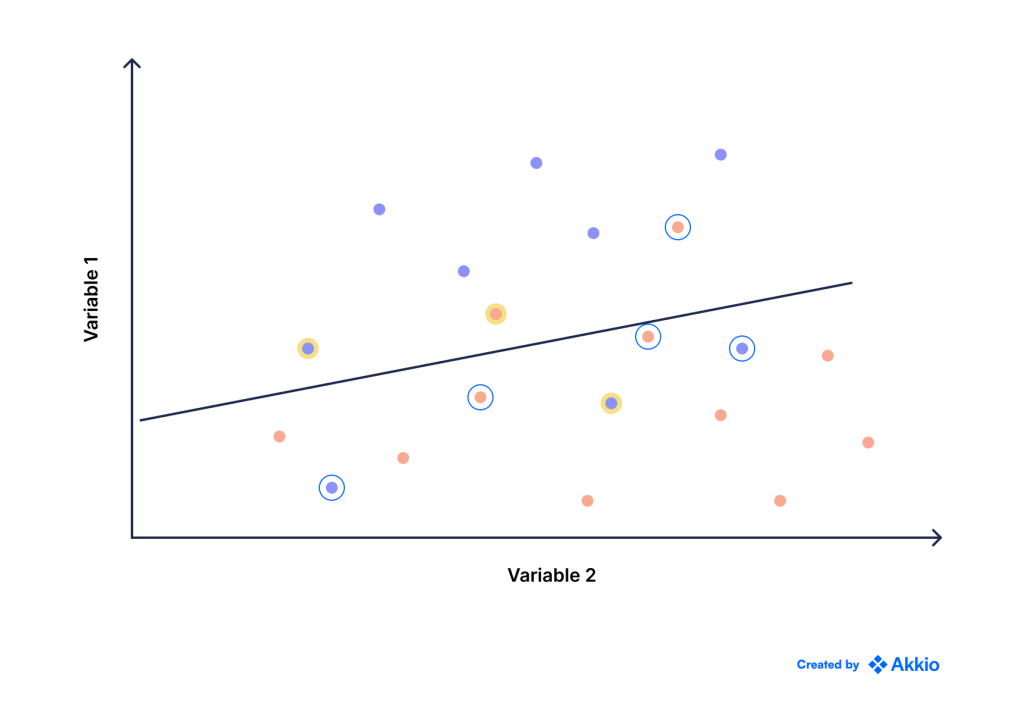

طبقه بندی کننده های نرم در مقابل سخت

گاهی اوقات، ممکن است نتوان با استفاده از یک خط مستقیم، نقاط را کاملاً طبقه بندی کرد. پس میتوانیم به روشهای غیرخطی متوسل شویم (که بعداً بحث شد)، اما فعلاً فقط به خطوط مستقیم پایبند باشیم.

در آن صورت، ممکن است مایل به استفاده از یک طبقهبندی ناقص باشیم. این طبقهبندیکننده نرم نیز نامیده میشود، زیرا همه نقاط را به درستی طبقهبندی نمیکند. از سوی دیگر، یک طبقهبندیکننده سخت به نمونههایی که تا کنون بحث کردهایم اشاره میکند، که تمام نقاط داده را کاملاً طبقهبندی میکند.

به مثال زیر توجه کنید:

در تصویر بالا، میبینیم که طبقهبندیکننده نرمی که انتخاب کردهایم، سه نقطه را به اشتباه طبقهبندی میکند (که با رنگ زرد مشخص شده است). در عین حال، دو نقطه آبی و دو نقطه قرمز (به رنگ آبی دایره شده) را نیز می بینیم که به شدت به خط نزدیک هستند و تقریباً اشتباه هستند. بنابراین، طبقه بندی کننده ما دارای حاشیه بسیار کمی بین دو کلاس است.

طبقهبندیکننده دیگری را که میتوانیم برای همان دادهها ترسیم کنیم، در نظر بگیرید:

در این مورد، ما پنج نقطه اشتباه طبقه بندی شده داریم (در مقایسه با سه نقطه قبلی)، اما خط دارای حاشیه گسترده تر و نقاط بسیار کمی است که نزدیک به خط هستند یا بسیار نزدیک به خط هستند.

این یک مبادله ذاتی با طبقهبندیکنندههای نرم را نشان میدهد. میتوانیم خطاها را به حداقل برسانیم یا حاشیه بین دو کلاس را به حداکثر برسانیم.

در حالی که جزئیات ریاضی را در اینجا نشان نمیدهیم، میتوانیم وزنهای متفاوتی را به هر یک از این گزینهها اختصاص دهیم، بسته به اینکه دقت بالاتر در مقایسه با داشتن یک مرز تمیزتر و کمتر مبهم اهمیت دارد.

این نمونهای از یک فراپارامتر مدل است: متغیری که برای الگوریتم مشخص میکنیم و شکلی را که مدل ما خواهد داشت را تعریف میکند یا به نوعی محدود میکند.

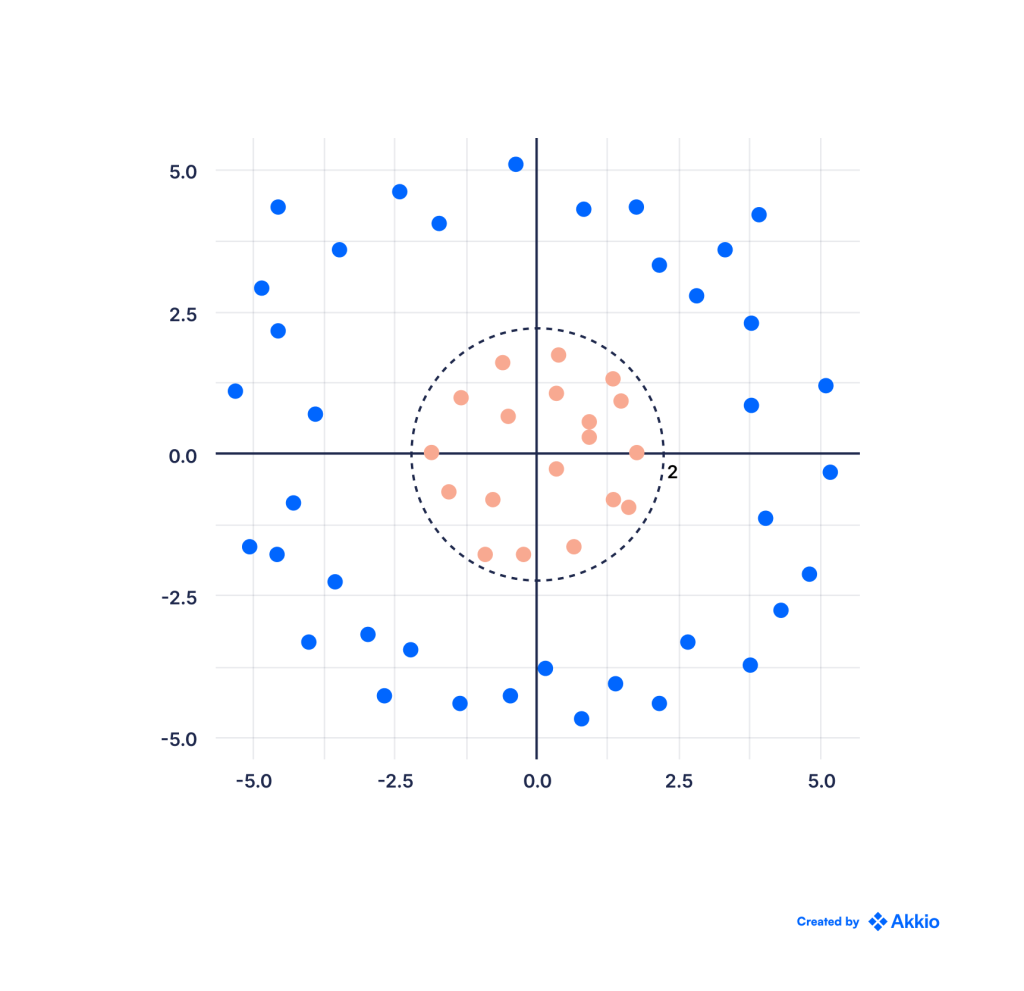

طبقه بندی کننده های غیر خطی SVM

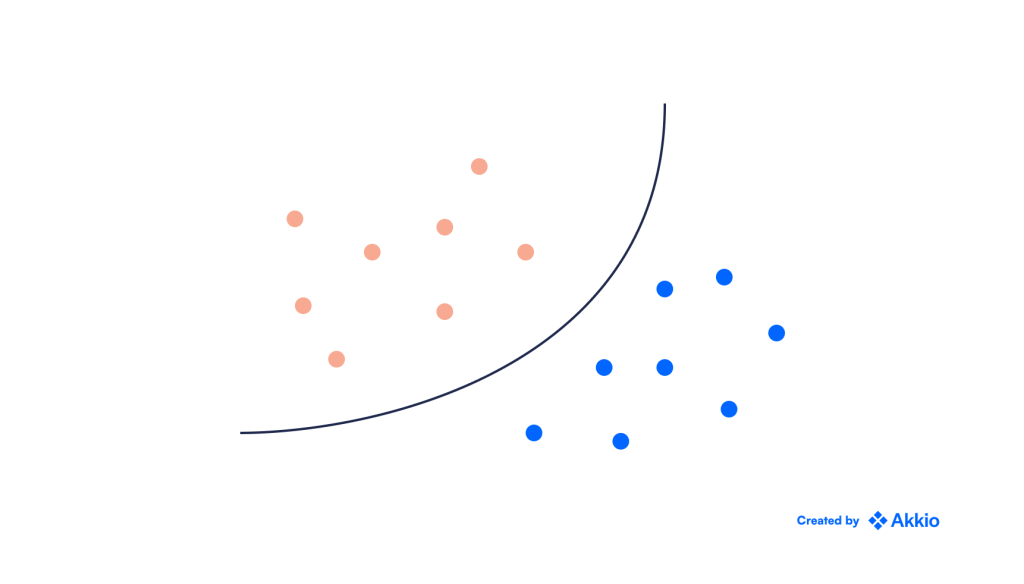

حال به مثال زیر توجه کنید:

در این حالت، می بینیم که در حالی که یک خط مستقیم نمی تواند این نقاط را جدا کند، یک دایره می تواند. چگونه می توانیم این مشکل را حل کنیم؟ همانطور که در بالا دیدیم، یک گزینه ممکن است استفاده از روش های غیرخطی مانند طبقه بندی KNN یا درختان طبقه بندی باشد.

از آنجایی که اینها روشهای ناپارامتریک هستند و شکل خاصی را برای مدل مشخص نمیکنند (مثلاً اینکه باید یک خط مستقیم باشد)، بهویژه برای مسائل غیرخطی مناسب هستند.

با این حال، SVM همچنین میتواند برای حل این مشکل با تبدیل دادهها برای دستیابی به جداسازی خطی بین کلاسها گسترش یابد. به عنوان مثال، میتوانیم ببینیم که تمام نقاط داخل یک دایره به شعاع 2 قرمز و نقاط خارج از آن آبی هستند.

در یک مورد ساده مانند این، اگر داده ها را از مختصات دکارتی به قطبی تبدیل کنیم. نمودار حاصل در زیر نشان داده شده است، که در آن محور x فاصله شعاعی از مبدا و محور y زاویه بر حسب رادیان است:

همانطور که مشاهده می شود، اکنون کلاس ها به راحتی با استفاده از یک خط مستقیم از هم جدا می شوند. بنابراین، ما به سادگی الگوریتم SVM را به این نسخه تبدیل شده از داده ها تغذیه می کنیم.

در سناریوهای پیچیده تر، به خصوص زمانی که مشکلات چند بعدی داریم و نمی دانیم که طبقه بندی کننده ایده آل مثلاً یک دایره است، ممکن است ندانیم از کدام تبدیل استفاده کنیم. در موارد دیگر، تبدیل ممکن است از نظر محاسباتی ناکارآمد باشد.

در این موارد میتوانیم با افزودن ابعاد بیشتر به آن مشکل را تبدیل کنیم. این به عنوان ترفند هسته یا SVM کرنل نامیده میشود و به ما اجازه میدهد تا مرزهای طبقهبندی غیرخطی مانند زیر ایجاد کنیم:

توضیح مکانیک یا ریاضی چگونگی و چرایی کارکرد SVM کرنل از حوصله این مقاله خارج است. با این حال، دانستن جزئیات مهمی است تا بتوانید درک جامعی از انواع مشکلاتی که الگوریتم SVM میتواند حل کند داشته باشید.

روش های هسته باید با SVM با احتیاط استفاده شوند. با افزودن ابعاد بیشتر به مسئله و اجازه دادن به مرزهای غیرخطی، مدلی انعطافپذیرتر ایجاد میکنیم. این به راحتی می تواند منجر به بیش از حد برازش شود.

درختان طبقه بندی

یکی دیگر از روشهای حل مسائل طبقهبندی – و روشی که برای مسائل غیرخطی بسیار مناسب است – استفاده از درخت تصمیم است.

از آنجایی که درختهای تصمیم را میتوان برای مسائل طبقهبندی و رگرسیون استفاده کرد (به بخش رگرسیون مراجعه کنید)، گاهی اوقات به الگوریتم CART (درخت طبقهبندی و رگرسیون) اشاره میشود.

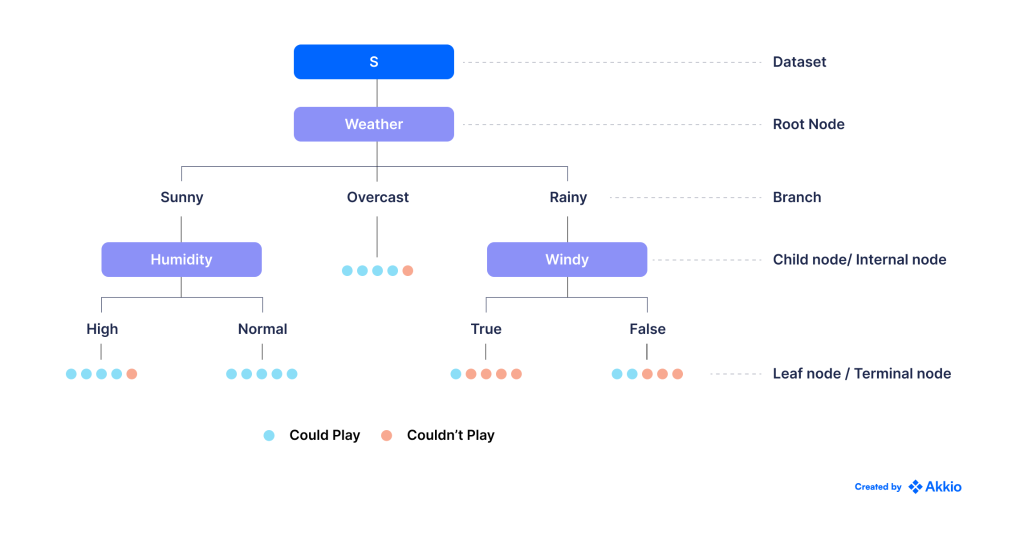

در این روش داده ها را بر اساس یک سری سوالات باینری (بله/خیر) به زیر مجموعه های کوچکتر و کوچکتر تقسیم می کنیم. درخت تصمیم زیر را برای تصمیم گیری در مورد اینکه آیا باید فوتبال بازی کنیم یا نه، بر اساس تأثیر آب و هوا در بازی های گذشته در نظر بگیرید:

توپها در گرههای برگ نشان میدهند که آیا ما توانستهایم یک بازی (آبی) را با شرایط آب و هوایی داده شده با موفقیت به پایان برسانیم یا اینکه بازی باید به دلیل آب و هوای نامناسب (قرمز) قطع شود.

می بینیم که در بیشتر روزهای بارانی با باد، مجبور شدیم بازی هایمان را لغو کنیم. به این ترتیب، حالت این گره برگ قرمز است، و ما هر روز بارانی و بادی آینده را به عنوان قرمز طبقهبندی میکنیم (یعنی احتمالاً در آن روزها نباید بازی کنیم).

توجه داشته باشید که درختهای تصمیم نیز نمونهای عالی از تفاوت روشهای یادگیری ماشینی با اشکال سنتیتر هوش مصنوعی هستند. شاید به خاطر داشته باشید که در بخش «تفاوت بین یادگیری ماشینی و هوش مصنوعی» در مورد چیزی به نام «سیستمهای خبره» بحث کردیم که سلسله مراتبی از قوانین if/else هستند که به رایانه اجازه میدهند تصمیم بگیرند.

درخت تصمیم نیز سلسله مراتبی از قوانین باینری است، اما تفاوت اصلی بین این دو این است که قوانین در یک سیستم خبره توسط یک متخصص انسانی تعریف میشوند. از سوی دیگر، درختهای تصمیم به خودی خود مشخص میکنند که معیارهای تقسیم در مرحله (یعنی قوانین) باید چه باشند – به همین دلیل است که میگوییم ماشین در حال یادگیری است.

چگونه این کار را انجام می دهد؟ ممکن است متوجه شده باشید که هر یک از گره های برگ عمدتاً از یک کلاس تشکیل شده است – برای مثال، گره Sunny + Normal Humidity عمدتا آبی است، در حالی که گره Rainy + Windy عمدتا قرمز است.

این بر اساس طراحی است. در هر مرحله از ساختن درخت تصمیم، کامپیوتر به تمام گزینه های ممکنی که دارد نگاه می کند و معیار تقسیم را انتخاب می کند که ناخالصی گره های بعدی را به حداقل می رساند – یعنی سعی می کند اطمینان حاصل کند که هر یک از گره ها دارای نقاطی هستند که متعلق به آنهاست. در صورت امکان فقط به یک کلاس.

البته، اگر به رایانه اجازه دهیم که دادهها را به زیر مجموعههای کوچکتر و کوچکتر تقسیم کند (به عنوان مثال، یک درخت عمیق)، در نهایت ممکن است به سناریویی برسیم که در آن هر گره برگ فقط یک (یا تعداد بسیار کمی) نقطه داده را شامل میشود. این ممکن است منجر به تطبیق بیش از حد شود. بنابراین حداکثر عمق مجاز یکی از مهمترین هایپرپارامترها هنگام استفاده از روشهای مبتنی بر درخت است.

یادگیری عمیق (Deep Learning)

یادگیری عمیق نمونه عالی دیگری از روش طبقه بندی است. در واقع، مدلهای یادگیری عمیق در حل مسائل با چندین کلاس عالی هستند.

آن ها همچنین در برخورد با روابط غیرخطی و مسائل غیرساختیافته مؤثر هستند، زیرا میتوانند تعاملات انتزاعیتر بین اصطلاحات مختلف را نشان دهند.

در بخش «یادگیری ماشین چیست»، مثالی از بانکی را در نظر گرفتیم که تلاش میکند تعیین کند آیا متقاضی وام احتمالاً نکول میکند یا خیر. این نمونه ای از مشکلی است که در آن داده های نسبتاً ساختار یافته ای داریم. ما برای هر متقاضی، مقادیر خاصی از معیارهای مختلف را می دانیم که فکر می کنیم برای حل مشکل آنها مهم و مرتبط هستند (مانند درآمد، امتیاز اعتباری و غیره). این معیارها اغلب به عنوان ویژگی ها یا پیش بینی کننده ها شناخته می شوند.

اما مشکل تشخیص چهره چطور؟ فرض کنید ما دو عکس از یک فرد داریم که به جهات مختلف نگاه می کند. اگر این دو تصویر را صرفاً به عنوان رشته ای از پیکسل ها به یک الگوریتم کلاسیک ML تغذیه کنیم، ممکن است تشخیص ندهد که آنها یک شخص هستند زیرا رشته پیکسل هایی که دریافت می کند ممکن است بر اساس شرایط رعد و برق، جهتی که در آن رعد و برق دریافت می کند، کاملاً متفاوت باشد. شخص نگاه می کند و غیره.

در عوض، برای ما منطقیتر خواهد بود که ابتدا ویژگیهای مفید را از تصویر استخراج کنیم و سپس آنها را به عنوان ورودی الگوریتم تغذیه کنیم.

به عنوان مثال، ممکن است بخواهیم رنگ پوست، شکل صورت، طول بینی، رنگ چشم و غیره را مشخص کنیم. از آنجایی که بدون در نظر گرفتن شرایط نوری یا جهت چهره آنها یکسان باقی می مانند، این ممکن است راه حل بسیار قوی تری باشد.

با این حال، این مشکل دیگری را ایجاد می کند زیرا ممکن است به الگوریتم دیگری برای یادگیری ماشینی نیاز داشته باشیم تا، به عنوان مثال، بین صورت و موی فرد تمایز قائل شویم. هنگامی که مو را شناسایی کردیم، ممکن است به یک الگوریتم یادگیری ماشین دوم برای تمایز بین انواع مختلف رنگ مو نیاز داشته باشیم (زیرا رنگ موها مجزا نیستند و موهای “قرمز” در واقعیت می توانند رنگ های بسیار متفاوتی داشته باشند).

به این ترتیب، ممکن است لازم باشد مسئله را به لایههای زیرمشکلات کوچکتر تقسیم کنیم (همچنین با استفاده از یادگیری ماشین حل شدهاند) تا ابتدا ویژگیهای ساختاریافته مرتبط را استخراج کنیم قبل از اینکه بتوانیم آنها را به الگوریتم نهایی که در واقع چهرهها را طبقهبندی میکند تغذیه کنیم.

از سوی دیگر، یادگیری عمیق سعی میکند این مشکل را دور بزند، زیرا نیازی به تعیین این ویژگیهای میانی ندارد. درعوض، میتوانیم به سادگی تصویر خام و بدون ساختار را به آن بدهیم و او به تنهایی متوجه شود که این ویژگیهای مرتبط چه میتواند باشد.

با انجام این کار، دو مزیت قابل توجه در مقایسه با الگوریتمهای یادگیری ماشین کلاسیک ارائه میکند:

ما ممکن است همیشه ندانیم که کدام ویژگی ها مرتبط هستند. به عنوان مثال، آیا طول مژه ها مرتبط است؟ به جای اینکه خودمان بفهمیم کدام ویژگیها مرتبط هستند، یک مدل یادگیری عمیق میتواند این کار را برای ما انجام دهد و به طور بالقوه ویژگیهایی را که ممکن است هرگز به آنها فکر نکردهایم شناسایی کند. و حتی اگر بدانیم ویژگی های مربوطه چیست، دیگر نیازی به صرف زمان برای استخراج این ویژگی ها نداریم زیرا شبکه عصبی این کار را برای ما انجام می دهد.

همچنین به همین دلیل است که الگوریتم های یادگیری عمیق اغلب جعبه سیاه در نظر گرفته می شوند. پیچیدگی ساختار آنها و تعداد زیاد لایهها در آنها به این معنی است که ما نمیتوانیم دقیقاً اطلاعاتی را در مورد ویژگیهای خاص استخراج کنیم، همانطور که ممکن است با یک مدل رگرسیون خطی انجام دهیم، که در آن ضریب برای هر ویژگی اطلاعات مستقیم و به راحتی قابل تفسیر را در مورد رابطه خطی میدهد. بین ویژگی ها و پاسخ.

چرا شبکه های عصبی عمیق هستند؟

همانطور که قبلاً بحث کردیم، یک شبکه عصبی زمانی “عمیق” است که حاوی چندین لایه باشد. در حالی که پزشکان مختلف ممکن است دقیقاً در آستانه شبکه عصبی «عمیق» متفاوت باشند، یک شبکه عصبی با بیش از سه لایه اغلب به عنوان «عمیق» در نظر گرفته میشود.

با این حال، این سوال پیش میآید که چرا شبکههای عصبی باید عمیق باشند؟

برای پاسخ به این سوال، به یاد بیاورید که چگونه، در بخش قبل، در مورد اینکه حل یک مشکل تشخیص چهره ممکن است نیاز به ایجاد خط لوله ای با چندین لایه از مشکلات فرعی به منظور استفاده از الگوریتم های کلاسیک ML داشته باشد، بحث کردیم.

خوب، معلوم می شود که الگوریتم های یادگیری عمیق نیز کم و بیش اینگونه کار می کنند. به عنوان مثال، در یک مسئله طبقهبندی تصویر، تحقیقات نشان داده است که هر یک از لایهها (یا گروهی از آنها) تمایل به استخراج قطعات خاصی از اطلاعات در مورد تصویر دارند. به عنوان مثال، برخی از لایه ها ممکن است بر روی اشکال در تصویر تمرکز کنند، در حالی که برخی دیگر ممکن است بر روی رنگ ها تمرکز کنند.

بنابراین، افزودن لایههای بیشتر میتواند به شبکههای عصبی اجازه دهد تا اطلاعات را به صورت دانهبندی بیشتری استخراج کنند – یعنی انواع بیشتری از ویژگیها را شناسایی کنند.

لایههای عمیقتر همچنین به شبکه عصبی اجازه میدهد تا درباره تعاملات انتزاعیتر بین ویژگیهای مختلف بیاموزد. به عنوان مثال، تأثیر امتیاز اعتباری بر توانایی یک فرد برای بازپرداخت وام ممکن است بر اساس دانشجو یا صاحب کسب و کار بسیار متفاوت باشد.

در یک تنظیم رگرسیون، دانشمند داده باید به صورت دستی چنین شرایط تعاملی را مشخص کند. اما همانطور که قبلاً بحث کردیم، ممکن است همیشه ندانیم که کدام عبارات تعامل مرتبط هستند، در حالی که یک شبکه عصبی عمیق می تواند این کار را برای ما انجام دهد.

مهارت آن با داده های بدون ساختار به یادگیری عمیق اجازه می دهد تا پیشرفت های عظیمی را در زمینه های بینایی کامپیوتری، تشخیص اشیا و پردازش زبان طبیعی ایجاد کند، که همگی شامل داده های بدون ساختار و طبقه بندی می شوند (به عنوان مثال، طبقه بندی اشیاء مختلف در یک تصویر به عنوان ماشین). یا یک عابر پیاده).

منابع داده آموزش یادگیری ماشین

یادگیری ماشینی با شناسایی الگوها در داده های گذشته و سپس استفاده از آنها برای پیش بینی نتایج آینده کار می کند. برای ایجاد یک مدل پیشبینی موفق، به دادههایی نیاز دارید که با نتیجه مورد علاقه مرتبط باشد. این داده ها می توانند اشکال مختلفی داشته باشند – از مقادیر عددی (دما، هزینه یک کالا و غیره) تا مقادیر زمانی (تاریخ، زمان های سپری شده) تا متن، تصاویر، ویدئو و صدا. خوشبختانه انفجار در فناوری محاسبات و حسگر همراه با اینترنت، ما را قادر ساخته است که داده ها را با نرخ های فزاینده ای ضبط و ذخیره کنیم. ترفند این است که دادههای مناسب را برای هر مشکل خاصی دریافت کنید – بیشتر کسبوکارها این را در پشتههای فناوری موجود خود ثبت میکنند، و بسیاری از این دادهها به صورت آنلاین رایگان در دسترس هستند.

داده های ساختاریافته در مقابل داده های بدون ساختار

دادههای ساختاریافته در مقابل دادههای غیرساختیافته موضوعی رایج در حوزه علم داده است، که در آن یک مجموعه داده ساختاریافته معمولاً طرحی کاملاً تعریف شده دارد و در جدولی با ردیفها و ستونها سازماندهی میشود. از سوی دیگر، دادههای بدون ساختار اغلب نامرتب و پردازش آنها دشوار است.

داده های ساختاریافته و بدون ساختار هر دو می توانند سوخت مدل های یادگیری ماشینی موفق باشند.

بیایید به جزئیات دادههای ساختاریافته در مقابل دادههای بدون ساختار، از جمله قالبهای داده، ذخیرهسازی داده، منابع داده، تجزیه و تحلیل و موارد دیگر بپردازیم.

فرمت های داده های ساختاریافته در مقابل غیرساختار

دادههای ساختاریافته قابل اندازهگیری هستند و جستجو و تجزیه و تحلیل آن آسان است و در قالبهای از پیش تعریفشده مانند CSV، Excel، XML، یا JSON ارائه میشوند، در حالی که دادههای بدون ساختار میتوانند در قالبهای متفاوتی از جمله PDF، تصاویر، صدا یا ویدیو باشند. .

داده های ساختاریافته معمولاً نتیجه یک طرح واره به خوبی تعریف شده است که اغلب توسط متخصصان انسانی ایجاد می شود. افزودن یا تغییر طرح واره داده های ساخت یافته برای افراد آسان است، اما انجام این کار با داده های بدون ساختار بسیار دشوار است.

بهطور خلاصه، دادههای ساختاریافته قابل جستجو و سازماندهی در جدول هستند و یافتن الگوها و روابط را آسان میکنند. تجزیه و تحلیل و به دست آوردن ارزش از داده های بدون ساختار، مانند استفاده از استخراج متن در فایل های PDF و به دنبال آن طبقه بندی متن، امکان پذیر است، اما این کار بسیار دشوارتر است.

منابع داده های ساخت یافته

بسیاری از ابزارهای تجاری محبوب، مانند Hubspot، Salesforce، یا Snowflake، منابع داده های ساخت یافته هستند.

مجموعه دادههای نمونه Akkio که در قالب CSV هستند نیز نمونههایی از دادههای ساختیافته هستند. به طور گسترده تر، هر فایل CSV یا Excel که به خوبی تعریف شده باشد، نمونه ای از داده های ساختاریافته است که میلیون ها نمونه از آن در سایت هایی مانند Kaggle یا Data.gov موجود است.

منابع داده بدون ساختار

به منظور مدل سازی پیش بینی، رایج ترین نوع داده های بدون ساختار متن است. این شامل فرمهای متنی، مانند فرمهای بازخورد مشتری، و همچنین ایمیلها، نظرات در سایتهای رسانههای اجتماعی، بررسی محصول یا حتی یادداشتهایی است که در طول تماسهای فروش یا جلسات کاری گرفته شدهاند.

همانطور که برجسته کردیم، داده های بدون ساختار فراتر از متن است و شامل صدا و تصویر می شود. برای مثال، بررسیهای YouTube منبع دیگری از دادههای بدون ساختار هستند. ویدئوهای یوتیوب همچنین شامل رونویسی یا گفتار به نوشتار تولید شده توسط هوش مصنوعی هستند. با توجه به این دادههای متنی، طبقهبندی متن میتواند برای استخراج این بررسیها برای بینش استفاده شود.

- ذخیره سازی داده های ساختاریافته در مقابل بدون ساختار

داده های ساختاریافته اغلب در انبارهای داده ذخیره می شوند در حالی که داده های بدون ساختار در دریاچه های داده ذخیره می شوند. یک انبار مجموعه داده های ساخت یافته را ذخیره می کند و معمولاً برای ذخیره سازی به پایگاه های داده سنتی مانند SQL Server و Oracle متکی است، در حالی که یک دریاچه داده مجموعه داده های کمتر تعریف شده ای را ذخیره می کند.

- داده های ساختار یافته در هوش مصنوعی دنیای واقعی

- داده های بدون ساختار در هوش مصنوعی دنیای واقعی

سایر مدلهای یادگیری ماشینی توسط دادههای بدون ساختار تغذیه میشوند.

تسلا از ناوگان خودروهای خودران خود برای جمع آوری اطلاعات در مورد الگوها و شرایط رانندگی استفاده می کند. این داده ها برای آموزش خودروهای خودران استفاده می شود که چگونه از برخورد اجتناب کنند و در شرایط مختلف رانندگی حرکت کنند.

نمونه دیگری در Google Photos دیده می شود. وقتی عکسی میگیرید، مدلهای یادگیری ماشینی Google تصویر را اسکن میکنند، یک نوع داده بدون ساختار، تا بفهمند در چه دستهای قرار میگیرد. سپس، کاربران میتوانند عکسهای بدون برچسب خود را بر اساس دستههایی مانند «طبیعت» یا «افراد» جستجو کنند.

تجزیه و تحلیل داده های ساخت یافته

اکثر ابزارهای تجزیه و تحلیل برای داده های ساختاریافته طراحی شده اند و تجزیه و تحلیل و به دست آوردن ارزش از داده های ساخت یافته را آسان تر از همیشه می کنند.

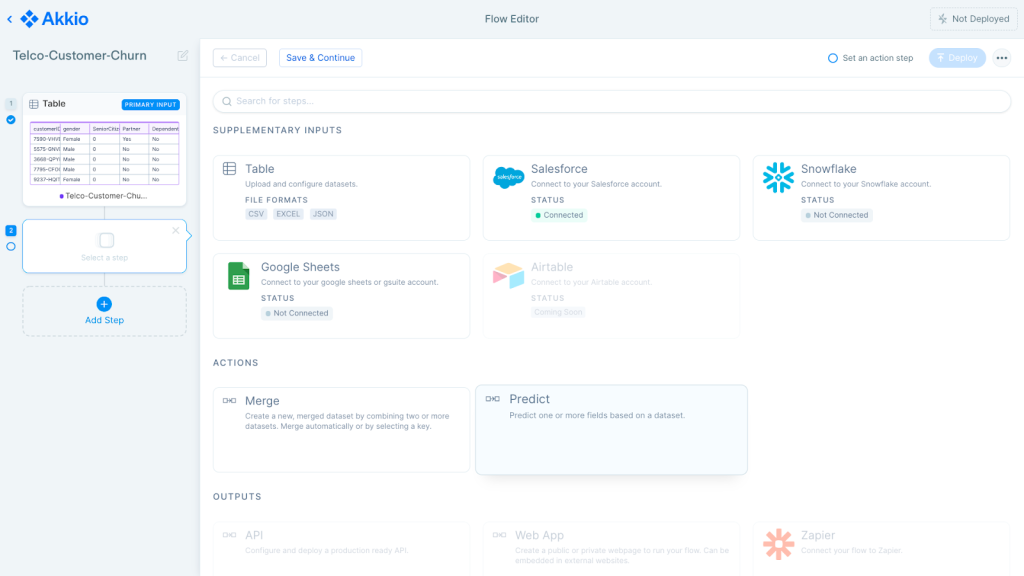

برای مثال، با Akkio، میتوانید دادههای ساختاریافته را برای ساخت و استقرار مدلهای هوش مصنوعی در عرض چند دقیقه بارگذاری کنید. در پسزمینه، الگوریتمهای یادگیری ماشین، دادههای جدولی را اسکن و هضم میکنند تا الگوها را بیابند و مدلی ایجاد میکنند که میتواند برای یافتن آن الگوها در دادههای جدید مستقر شود.

تجزیه و تحلیل داده های بدون ساختار

تجزیه و تحلیل داده های بدون ساختار یک کار کمتر رایج است، اما همچنان برای کسب و کارهایی که به دنبال کسب ارزش از فایل های PDF، داده های تصویری و صوتی و غیره خود هستند، بسیار مهم است.

تجزیه و تحلیل داده های بدون ساختار یک کار پیچیده است، به همین دلیل است که توسط بسیاری از مشاغل نادیده گرفته می شود.

پردازش و درک داده های بدون ساختار ممکن است دشوار باشد زیرا آشفته و در قالب های مختلف هستند. داده های بدون ساختار نیز ممکن است به جای کمی، کیفی باشند و تجزیه و تحلیل آن را حتی سخت تر کند.

یکی از موارد استفاده برای داده های بدون ساختار، تجزیه و تحلیل نظرات و نظرات در رسانه های اجتماعی، هم از طرف شرکت خود و هم از رقبا، برای اطلاع رسانی استراتژی رقابتی است.

مورد دیگر، تحلیل بازار برای یافتن فرصت های جدید است. با تجزیه و تحلیل داده های بازار بدون ساختار، مانند پست های رسانه های اجتماعی که نیازهای مشتری را ذکر می کنند، کسب و کارها می توانند فرصت هایی را برای محصولات جدید و ویژگی هایی که ممکن است نیازهای این مشتریان بالقوه را برآورده کند، کشف کنند.

داده های کمی در مقابل داده های کیفی/دسته ای

داده های کمی مجموعه ای عددی از اطلاعات است، مانند قد و وزن هر فرد در یک گروه، در کنار اندازه گروه. داده های کمی را می توان بیشتر به دو زیر دسته تقسیم کرد: داده های گسسته و پیوسته.

دادههای گسسته شامل اندازهگیریهایی نمیشود که در امتداد یک طیف هستند، بلکه در عوض به شمارش اعداد، مانند تعداد محصولات در سبد خرید مشتری، یا تعداد تراکنشهای مالی اشاره میکنند. از سوی دیگر، دادههای پیوسته به دادههایی اشاره دارد که میتوانند به طور معناداری به واحدهای کوچکتر تقسیم شوند یا در مقیاسی مانند درآمد مشتری، حقوق کارمند یا اندازه دلار یک تراکنش مالی قرار گیرند.

داده های کیفی غیر عددی هستند، مانند اینکه آیا یک معامله تقلبی است یا خیر، آیا یک بررسی دارای احساسات مثبت یا منفی است، یا اینکه آیا یک معامله فروش دارای احتمال بسته شدن بالا یا پایین است. دادههای کیفی تا حد زیادی مقولهای هستند، اما مواردی مانند متن را نیز شامل میشوند، خواه توییت، بلیط پشتیبانی مشتری یا اسناد باشد. به معنای واقعی کلمه، داده های مقوله ای صرفاً داده های مربوط به دسته ها هستند، در حالی که داده های کمی به کمیت ها مربوط می شود.

بیایید عمیقتر به تفاوتهای بین دادههای کمی و کیفی بپردازیم، با تمرکز روی دادههای طبقهای.

چگونه بفهمیم که داده های شما کمی هستند یا دسته بندی

تعیین اینکه آیا داده های شما مقوله ای یا کمی هستند می تواند دشوار باشد، اما چند مرحله وجود دارد که می توانید برای پیدا کردن آن انجام دهید.

اگر داده های شما دارای محدوده عددی مقادیر مانند درآمد، سن، اندازه تراکنش یا موارد مشابه باشد، کمی است. از سوی دیگر، اگر دستههایی مانند «بله»، «شاید» و «خیر» وجود داشته باشد، دستهبندی است.

همچنین باید نوع پاسخ هایی را که از داده های خود انتظار دارید در نظر بگیرید. آیا منتظر پاسخی هستید که طیفی از مقادیر یا فقط یک مجموعه ارزش داشته باشد؟ اگر انتظار یک مجموعه از ارزشها را دارید، مانند «تقلب» یا «نه کلاهبرداری»، آنوقت مقولهای است. اگر انتظار طیف وسیعی از مقادیر را دارید، مانند یک مقدار دلار مشخص، پس کمی است.

نمونه هایی از مدل های هوش مصنوعی که می توانید با داده های کمی بسازید

داده های کمی را می توان برای تامین انرژی طیف گسترده ای از مدل های هوش مصنوعی استفاده کرد. بیایید چند نمونه را بررسی کنیم.

پیشبینی ترافیک سایت، با توجه به دادههای ترافیک تاریخی (مثلاً اگر قرار است Google Ads را شنبه شب اجرا کنید، تعداد ترافیک مورد انتظار شما چقدر است؟)

تعیین تعداد مشتریانی که چیزی را میخرند، با توجه به فراوانی تراکنشهای تاریخی (مثلاً اگر تبلیغی را اجرا میکنید، چند نفر یک کالا را خریداری میکنند؟)

پیشبینی میزان درآمدی که با توجه به درآمد تاریخی خواهید داشت (مثلاً چند نفر روی یک تبلیغ کلیک میکنند و سپس خرید میکنند؟)

تعیین سطوح موجودی شما با توجه به ارقام فروش تاریخی (مثلاً سطح موجودی شما با توجه به ارقام فروش شما چگونه باید باشد؟)

الگوریتم های کمی یادگیری ماشین می توانند از اشکال مختلف تحلیل رگرسیون استفاده کنند، به عنوان مثال، برای یافتن رابطه بین متغیرها.

برای ارائه یک مثال ساده، اگر یک متغیر وزن بیمار و متغیر دیگر قد بیمار باشد، با اجرای تحلیل رگرسیون روی مجموعهای از بیماران، رابطه بین این متغیرها را میتوان یافت.

نمونه هایی از مدل های هوش مصنوعی که می توانید با داده های طبقه بندی شده بسازید.

داده های طبقه بندی شده همچنین می تواند طیف گسترده ای از موارد استفاده از هوش مصنوعی را تامین کند. در اینجا فقط چند نمونه آورده شده است.

طبقهبندی مشتریان بر اساس گروههای رفتاری که در آن قرار میگیرند به دستههای مختلف (مثلاً از چه نوع دستگاهی برای مرور وبسایت شما استفاده میکنند؟ آیا لباس یا کفش میخرند؟)

طبقه بندی تبلیغات خود به دسته های مختلف بر اساس اثربخشی آنها (به عنوان مثال آیا این تبلیغ نسبت به تبلیغ دیگری کلیک بیشتری جذب می کند؟)

الگوریتمهای طبقهبندی یادگیری ماشین شامل الگوریتمهای خوشهبندی برای شناسایی گروهها در یک مجموعه داده استفاده میشوند، جایی که گروهها بر اساس شباهت هستند. نامهای الگوریتم فنی شامل Naïve Bayes و K-nearest همسایگان است.

درک پیچیدگیهای این الگوریتمهای پیچیده پیشنیاز مدلسازی هوش مصنوعی بود، اما اکنون میتوانید این مدلها را در عرض چند دقیقه بسازید و بدون نیاز به تخصص فنی بسازید.

چه چیزی بهتر است: داده های کمی یا طبقه ای؟

هر نوع داده دارای مزایا و معایبی است و اینکه از کدام نوع داده استفاده شود بستگی به موقعیت دارد.

دادههای کمی ذاتاً دقیقتر از دادههای طبقهبندی هستند، زیرا جزئیات بیشتر در دادههای کمی وجود دارد. به عنوان مثال، ارتفاع “72.5 اینچ” بسیار دقیق تر از رده “قد بلند” است. درآمد «12000 دلار» بسیار دقیق تر از دسته «فقیر» است.

با استفاده از دسته ها می توان برخی از اطلاعات را از دست داد.

به عنوان مثال، یک آمریکایی با درآمد سالانه 0 دلار و دیگری با درآمد سالانه 12000 دلار هر دو در یک طبقه قانونی – فقر – حتی با تفاوت های قابل توجه در موقعیت های زندگی طبقه بندی می شوند. به طور مشابه، شخصی با دارایی خالص 30 میلیون دلار و شخصی با دارایی خالص 100 میلیارد دلار هر دو به عنوان افراد با ارزش خالص فوق العاده بالا طبقه بندی می شوند، حتی در حالی که ده ها هزار نفر در دسته قبلی وجود دارند و فقط تعداد کمی از افراد در این دسته هستند. دسته دوم

یکی از معایب دادههای کمی این است که درک و مدلسازی آن از دادههای طبقهبندی سختتر است. داده های طبقه بندی ذاتا داده ها را با کاهش تعداد نقاط داده ساده می کند.

چه چیزی رایج تر است: داده های کمی یا طبقه ای؟

هیچ پاسخ ساده ای در مورد اینکه نوع داده رایج تر است، وجود ندارد.

جمع آوری داده های طبقه بندی شده اغلب آسان تر است. به عنوان مثال، با توجه به نمایه شخصی فیس بوک، احتمالاً می توانید اطلاعاتی در مورد نژاد، جنسیت، غذای مورد علاقه، علایق، تحصیلات، حزب سیاسی و موارد دیگر دریافت کنید که همگی نمونه هایی از داده های طبقه بندی شده هستند.

از سوی دیگر، احتمالاً نمیتوانید درآمد دقیق، وزن، عادات خرج کردن یا سایر معیارهای کمی دقیق (به استثنای برخی از موارد استثنایی مانند سن) را بدانید.

با این حال، وضعیت کاملاً متفاوت است، زیرا فیس بوک حجم زیادی از داده ها را در مورد هر یک از کاربران خود جمع آوری می کند که بیشتر آنها کمی هستند، مانند مدت زمان صرف شده برای مشاهده یک پست، تعداد پست های مشاهده شده، تعداد. تعداد بازدید پروفایل، تعداد کلیک روی لینک، تعداد برنامه باز شده و غیره.

در نهایت، ما هر روز، تقریباً با هر اقدامی که انجام میدهیم، مقادیر زیادی از هر دو نوع داده را ایجاد میکنیم. وقتی گوشی هوشمند جدیدی را برمی دارید، حسگرها با ردیابی موقعیت مکانی دقیق گوشی شما در هر نقطه از زمان، که نمونه ای از داده های کمی است، تشخیص می دهند که آن را گرفته اند. سپس، همانطور که تشخیص می دهد تلفن شما برداشته شده است، ممکن است متغیری مانند “وضعیت” را به جای “غیرفعال” به “فعال” تغییر دهد و باعث روشن شدن صفحه قفل گوشی شما شود..

سری زمانی

دادههای سری زمانی نوعی داده است که رویدادهایی را که در طول زمان اتفاق میافتند ثبت میکند، که به ویژه در پیشبینی رویدادهای آینده مفید است.

برای ارائه یک مثال بسیار ساده، در اینجا مجموعه داده سری زمانی با سه نقطه داده آورده شده است: در سال 1975، دمای سطح جهانی زمین 0.0 درجه سانتیگراد غیرعادی بود، در سال 1995 + 0.5 درجه سانتیگراد بالاتر از حد معمول بود، و در سال 2015 این دمای 0.9 + بود. درجه سانتیگراد بالاتر از حد معمول است.

یکی از اصول کلیدی دادههای سری زمانی این است که وقتی چیزی اتفاق میافتد به همان اندازه مهم است که چه اتفاقی میافتد. به عنوان مثال، در بازاریابی، مدت زمانی که مشتری طی می کند تا مراحل قیف بازاریابی را طی کند، پیش بینی کننده مهم درآمد است.

برنامه های کاربردی رایج

یکی از مهمترین کاربردهای داده های سری زمانی، پیش بینی است. این به این دلیل است که گذشته بهترین پیش بینی کننده آینده است. بیایید برخی از کاربردهای رایج دادههای سری زمانی، از جمله پیشبینی و موارد دیگر را بررسی کنیم.

سفر بازاریابی

بازاریابی یک سفر است و سفر مشتری از طریق قیف بازاریابی می تواند غیرقابل پیش بینی به نظر برسد.

با این حال، راههای زیادی برای پیشبینی سفر مشتری و رسیدن به آنها در زمان مناسب وجود دارد تا جذب مشتری و نرخ تبدیل افزایش یابد. با درک سفرهای مشتری، بازاریابان همچنین می توانند یک تجربه محتوای مرتبط تر و قانع کننده تر برای هر مرحله از سفر ایجاد کنند.

به عنوان مثال، اگر در حال اجرای یک کمپین بازاریابی در اینستاگرام هستید و میخواهید بدانید تبلیغات شما چند کلیک دریافت میکند، میتوانید کلیکها را بر اساس دادههای تاریخی پیشبینی کنید.

برای مثال دیگر، پیشبینی سریهای زمانی میتواند برای پیشبینی زمان خرید بعدی مشتریان استفاده شود. این به شرکت ها اجازه می دهد تا در مورد زمان عرضه محصولات جدید و زمان ارسال ایمیل یا سایر پیام های مصرف کننده تصمیم گیری کنند.

نرخ اجرا درآمد

نرخ اجرا درآمد پیش بینی درآمد بر اساس آنچه در گذشته اتفاق افتاده است.

این یک معیار مهم برای شرکت ها است زیرا به آنها کمک می کند تا برای نیازهای درآمدی آینده برنامه ریزی کنند. نرخ اجرای درآمد یک معیار سالانه است که به طور سنتی با ضرب متوسط درآمد در ماه در 12 یا میانگین درآمد در هر سه ماه در 4 محاسبه می شود. این یک تخمین تقریبی از میزان درآمد شرکت در سال را نشان می دهد.

با این حال، این یک روش بسیار خشن برای تخمین درآمد است که می تواند بسیار نادرست باشد. به عنوان مثال، کسبوکارهایی مانند مراکز تناسب اندام معمولاً در ژانویه به دلیل تصمیمگیریهای سال نو عملکرد بهتری دارند، بنابراین نمیتوانند درآمد را با روشهای سنتی بهطور دقیق پیشبینی کنند. وضعیت برعکس برای یک شرکت محوطه سازی صادق است، که احتمالاً در ژانویه تجارت زیادی نخواهد داشت.

تعدادی از متغیرهای دیگر نیز بر درآمد تأثیر میگذارند، از بودجههای پویا گرفته تا رقبای جدید یا نوآوری محصول جدید. محاسبات سنتی که صرفاً مبتنی بر چند برابر شدن درآمد تاریخی است، همه این عوامل دیگر را نادیده می گیرد.

با استفاده از پیشبینی Akkio، میتوانید نرخ درآمد را بر اساس هر تعداد متغیر پیچیده در دادههای خود بهطور دقیق پیشبینی کنید.

ارزش سهام یا کریپتو

پیشبینی قیمت سهام و کریپتو بسیار دشوار است، بهویژه با توجه به مشکلات فنی ساخت دستی و استقرار مدلهای پیشبینی.

گفته می شود، برای سرمایه گذارانی که علاقه مند به پیش بینی دارایی ها هستند، داده های سری زمانی و یادگیری ماشینی ضروری است. با Akkio، می توانید داده های سری زمانی سهام و دارایی های رمزنگاری شده را برای پیش بینی قیمت ها متصل کنید.

مهم است که به یاد داشته باشید که سهام و رمزارز انواع مختلفی از سرمایه گذاری هستند، زیرا بازارهای کریپتو بسیار کوچکتر و بی ثبات تر هستند. سرمایه گذاران باید هنگام سرمایه گذاری در سهام و ارزهای دیجیتال مراقب احساسات خود باشند.

سلامت دستگاه

سازندگان از هوش مصنوعی سری زمانی برای نگهداری پیش بینی و نظارت بر سلامت تجهیزات استفاده می کنند. سیستم های هوش مصنوعی می توانند تشخیص دهند که چه زمانی باید تغییراتی برای بهبود کارایی ایجاد شود. آنها همچنین می توانند پیش بینی کنند که چه زمانی تجهیزات خراب می شود و قبل از وقوع آن هشدار ارسال می کنند.

این فناوریها با عدم صرف هزینه برای تعمیرات غیرمنتظره یا تعویض فوری ماشینآلات در زمانی که دیگر کار نمیکنند، در هزینه تولیدکنندگان صرفهجویی میکنند.

مجموعه داده های سری زمانی

برای افراد غیر متخصص، یافتن مجموعه داده های سری زمانی با کیفیت بالا یک چالش است. خوشبختانه، تعداد زیادی از منابع مجموعه زمانی رایگان و با کیفیت بالا به صورت آنلاین موجود است.

بیایید چند منبع داده سری زمانی را بررسی کنیم.

مخزن سری زمانی UCI

مخزن UCI دارای ۴۸ مجموعه داده سری زمانی است که از کیفیت هوا گرفته تا دادههای پیشبینی فروش را شامل میشود.

بیشتر دادهها در قالب CSV ارائه میشوند، بنابراین خواندن آن با ابزارهایی مانند Akkio آسان است، بدون نیاز به پیش پردازش دستی. فقط یک مجموعه داده را متصل کنید، و شما آماده هستید!

شاخص های توسعه جهانی بانک جهانی

بانک جهانی بانک اطلاعات گستردهای با ۷۹ پایگاه داده برای ۲۶۴ کشور با دادههای مربوط به سال ۱۹۶۰ ارائه میکند.

برای مثال، پایگاه داده شاخصهای توسعه جهانی، شامل بیش از 1440 ستون داده برای انتخاب میشود، از شاخصهای سطح بالا مانند «درصد دسترسی به برق» تا شاخصهای بسیار تخصصی مانند «جمعیت روستایی ساکن در مناطقی که ارتفاع آن زیر 5 متر است». پایگاه داده آمار آموزش شامل تقریبا 4000 ستون داده است.

پاسخ آسانی برای تعداد مجموعه داده های سری زمانی ارائه شده وجود ندارد، اما اگر هر مجموعه داده سری زمانی بالقوه را به عنوان یک مشکل تک متغیره در نظر بگیرید، میلیون ها مجموعه داده تنها از این منبع وجود دارد (79 پایگاه داده در 264 کشور با میانگین 2000 ستون های داده).

ملاحظات ویژه برای داده های سری زمانی

دادههای سری زمانی به دلایل مختلفی میتوانند یک نوع داده بسیار دشوار برای کار کردن باشند. ما برخی از ملاحظات ویژه را که باید هنگام کار با داده های سری زمانی در نظر داشته باشید، برجسته کرده ایم.

دادههای سری زمانی متوالی هستند، اما بسیاری از الگوریتمها برای پیشبینی آینده اینطور نیستند.

در مجموعه داده های سری زمانی، جنبه زمانی بسیار مهم است، اما بسیاری از الگوریتم های یادگیری ماشین از این جنبه زمانی استفاده نمی کنند، که مدل های گمراه کننده ای را ایجاد می کند که در واقع آینده را پیش بینی نمی کنند.

به عنوان مثال، یک مدل «راهپیمایی تصادفی» یک فرآیند تصادفی است، به این معنی که پیشبینی دقیق نتایج آینده از دادههای تاریخی برای آن امکانپذیر نیست.

برای مثال دیگر، مدلهای رگرسیون پایه، همبستگی زمانی را در دادههای مشاهدهشده نادیده میگیرند و مقدار بعدی سریهای زمانی را صرفاً بر اساس روشهای رگرسیون خطی پیشبینی میکنند.

علاوه بر این، بسیاری از مدلهای سری زمانی با یافتن همبستگیهای کاذب، به جای متغیرهای علّی، به راحتی میتوانند به دادهها «اضافه شوند».

برای مثال، رابطه مثبتی بین فروش بستنی و قتل وجود دارد، اما بدیهی است که نه به این دلیل که خوردن بستنی باعث میشود که بخواهید مردم را بکشید. این همان چیزی است که به عنوان “همبستگی جعلی” شناخته می شود.

در مورد بستنی فروشی و قتل، اتفاقی که می افتد این است که فروش بستنی در تابستان افزایش می یابد، یعنی زمانی که افراد بیشتری به بیرون از خانه می روند و باعث افزایش طبیعی جرم و جنایت می شود (وقتی همه در زمستان در داخل بسته می شوند، جرایم کمتری انجام می شود. در مقابل، مثلاً، زمانی که یک رویداد ورزشی در تابستان با 50000 شرکت کننده در یک استادیوم وجود دارد).

تولید مدلی که آینده را از روی داده های سری زمانی پیش بینی می کند، کار بسیار زیادی است.

مدلسازی دادههای سری زمانی یک تلاش فشرده است که نیاز به پیش پردازش، تمیز کردن دادهها، آزمایشهای ثابت، روشهای ثابتسازی مانند تغییر روند یا تفاوت، یافتن پارامترهای بهینه و موارد دیگر دارد.

انجام این کار به صورت دستی به تخصص فنی بالایی نیاز دارد، البته به تعهد زمانی زیاد نیز اشاره نمی کنیم. با Akkio، این فرآیندهای پیچیده در back-end خودکار می شوند، بنابراین می توانید داده ها را بدون زحمت پیش بینی کنید.

دادههای سری زمانی اغلب در مورد پیشبینی آینده دقیق نیستند، زیرا بسیاری از چیزهایی که در گذشته اتفاق افتاده است دیگر به آینده مرتبط نیستند.

اگر تا به حال به سرمایه گذاری فکر کرده اید، احتمالاً یک سلب مسئولیت مالی در امتداد این موارد خوانده اید: “عملکرد گذشته تضمینی برای نتایج آینده نیست.”

این در واقع یک الزام قانونی برای شرکت های مدیریت دارایی است که چنین سلب مسئولیتی را ارائه کنند، زیرا، خوب، واقعاً راهی برای دانستن آینده وجود ندارد. بهترین کاری که می توانیم انجام دهیم این است که احتمالات را به مقادیر خاصی اختصاص دهیم.

در واقع، حتی ایجاد احتمالات دقیق نیز بسیار چالش برانگیز است، زیرا جهان دائما در حال تغییر است. پیشبینی موارد COVID-19 نمونهای عالی از چالشهای پیشبینی سریهای زمانی است، زیرا تقریباً همه پیشبینیها شکست خوردند.

حتی در حال حاضر، با توجه به اینکه با توجه به واکسنهای جدید، سویههای جدید و مقررات در حال تغییر پیرامون سفر، فاصلهگذاری اجتماعی، قرنطینه و غیره، بسیاری از دادههای گذشته دیگر برای آینده مرتبط نیستند، پیشبینی دقیق بسیار دشوار است.

مهندسی ویژگی برای داده های سری زمانی

مهندسی ویژگی فرآیند ایجاد ویژگی های جدید از داده های موجود است.

یک چالش با داده های سری زمانی این است که اغلب ثابت نیستند. ایستایی به این معنی است که یک سری زمانی دنباله ای از مشاهدات یک متغیر است که در زمان های مساوی با فاصله گرفته شده است. اگر مشاهدات در زمان به یک اندازه فاصله داشته باشند و هیچ روند یا فصلی نداشته باشند، ثابت است.

ایجاد دادههای ثابت شکلی از مهندسی ویژگی است و دو روش رایج برای تبدیل سریهای زمانی به دادههای ثابت، تفاوت و تبدیل است.

گفته میشود، با ابزارهای هوش مصنوعی بدون کد مانند Akkio، میتوانید مدلهای سری زمانی را بدون نیاز به مهندسی ویژگی دستی بسازید و استقرار دهید، زیرا این کار به طور خودکار پس از اتصال مجموعه داده انجام میشود.

برای آموزش یک مدل ML به چه مقدار داده نیاز دارم؟

داده ها سوختی هستند که باعث می شود یادگیری ماشین تیک بخورد. در بیشتر موارد، هرچه دادههای بیشتری داشته باشید، مدل شما دقیقتر خواهد بود، اما موارد زیادی وجود دارد که میتوانید با کمترین هزینه از پس آن برآیید.

مدل های یادگیری ماشینی ماشین های تطبیق الگو هستند. آنها فقط می توانند الگوهایی را که قبلاً دیده شده اند، ضبط و پیش بینی کنند. این یکی از موارد مهم در یادگیری ماشینی است. اگر میخواهید پیشبینی کنید که با دادههای جدید چه اتفاقی میافتد، مدل باید قبلاً دادههای مشابهی را دیده باشد.

همچنین مهم است که توجه داشته باشید که هیچ قانون طلایی برای مقدار داده مورد نیاز شما وجود ندارد. به عنوان مثال، در حالی که مجموعه داده آزمایشی امتیازدهی سرنخ Akkio دارای بیش از 40000 ردیف داده است، مجموعه داده آزمایشی طبقهبندی متن تنها دارای 1000 ردیف داده است و هر دو تقریباً 90 درصد دقت دارند. در همین حال، مجموعه داده نمایشی تقلب کارت اعتباری نزدیک به 300000 ردیف داده دارد!

بهتر است فرآیند مدلسازی مجموعه دادههای خود را بررسی کنید و ببینید برای به دست آوردن دقت بالا چه چیزی لازم است.

آیا داده های خیلی کمی دارید؟

مدلهای یادگیری ماشینی دقیق را میتوان با چند صد ردیف داده ایجاد کرد. اگر واقعاً دادههای بسیار کمی دارید، مثلاً کمتر از چند صد ردیف، میتوانید چند چیز را امتحان کنید.

یکی افزایش داده است: فرآیندی که در آن داده ها با افزودن نمونه های جعلی داده تولید می شوند. همچنین می توانید در سایر مجموعه داده ها، اعم از داخلی یا خارجی، در ستون های مشترک ادغام شوید تا اندازه کلی مجموعه داده را افزایش دهید.

برای مثال، فرض کنید در حال ساخت مدلی برای طبقهبندی بلیطهای پشتیبانی مشتری بر اساس فوریت هستید. اگر به دادههای بیشتری نیاز دارید، باید مطمئن شوید که خط لولهای دارید که این دادهها را برای شما تولید میکند. در چنین حالتی، تیم های پشتیبانی شما باید فوریت بلیط های دریافتی را برچسب گذاری کنند، بنابراین می توانید بعداً این داده ها را برای تقویت مدل یادگیری ماشین خود صادر کنید.

بسته به مورد استفاده، حتی میتوانید به پلتفرمهای جمعسپاری مانند Amazon Mechanical Turk روی بیاورید. این پلتفرمها به شما امکان میدهند افرادی را از سراسر جهان استخدام کنید تا کارهای کوچکی را با قیمتهای پایین برای شما انجام دهند، مانند جمعآوری و برچسبگذاری دادهها. اگر یک شرکت کوچک با منابع محدود هستید، ممکن است نخواهید این کار را انجام دهید، اما اگر شرکت بزرگی هستید و به سرعت داده های بیشتری می خواهید، این ممکن است گزینه خوبی برای شما باشد.

روش دیگر حذف دادهها از اینترنت است، که باز هم به موارد استفاده وابسته است، اما با توجه به ماهیت باز بودن بسیاری از دادههای اینترنتی، مانند پستهای رسانههای اجتماعی، به طور بالقوه راهی آسان برای افزایش اندازه مجموعه داده شما است.

آیا داده های زیادی دارید؟

مواردی وجود دارد که به نظر می رسد داده های زیادی دارید. اگر مجموعه داده شما خیلی بزرگ باشد، کاوش و درک آنچه که داده ها به شما می گویند دشوار می شود. این مورد به ویژه در مورد داده های بزرگ به ترتیب چندین گیگابایت یا حتی ترابایت است که با ابزارهای معمولی مانند اکسل یا حتی کد معمولی پایتون پاندا قابل تجزیه و تحلیل نیستند.

با توجه به اینکه امکان ساخت مدلهای یادگیری ماشینی با کیفیت بالا با مجموعه دادههای بسیار کوچکتر وجود دارد، این مشکل را میتوان با نمونهگیری از مجموعه داده بزرگتر و استفاده از نمونه مشتقشده و کوچکتر برای ساخت و استقرار مدلها حل کرد.

مدلهای یادگیری ماشینی دقیق را میتوان با چند صد ردیف داده ایجاد کرد. اگر واقعاً دادههای بسیار کمی دارید، مثلاً کمتر از چند صد ردیف، میتوانید چند چیز را امتحان کنید.

یکی افزایش داده است: فرآیندی که در آن داده ها با افزودن نمونه های جعلی داده تولید می شوند. همچنین می توانید در سایر مجموعه داده ها، اعم از داخلی یا خارجی، در ستون های مشترک ادغام شوید تا اندازه کلی مجموعه داده را افزایش دهید.

برای مثال، فرض کنید در حال ساخت مدلی برای طبقهبندی بلیطهای پشتیبانی مشتری بر اساس فوریت هستید. اگر به دادههای بیشتری نیاز دارید، باید مطمئن شوید که خط لولهای دارید که این دادهها را برای شما تولید میکند. در چنین حالتی، تیم های پشتیبانی شما باید فوریت بلیط های دریافتی را برچسب گذاری کنند، بنابراین می توانید بعداً این داده ها را برای تقویت مدل یادگیری ماشین خود صادر کنید.

بسته به مورد استفاده، حتی میتوانید به پلتفرمهای جمعسپاری مانند Amazon Mechanical Turk روی بیاورید. این پلتفرمها به شما امکان میدهند افرادی را از سراسر جهان استخدام کنید تا کارهای کوچکی را با قیمتهای پایین برای شما انجام دهند، مانند جمعآوری و برچسبگذاری دادهها. اگر یک شرکت کوچک با منابع محدود هستید، ممکن است نخواهید این کار را انجام دهید، اما اگر شرکت بزرگی هستید و به سرعت داده های بیشتری می خواهید، این ممکن است گزینه خوبی برای شما باشد.

روش دیگر حذف دادهها از اینترنت است، که باز هم به موارد استفاده وابسته است، اما با توجه به ماهیت باز بودن بسیاری از دادههای اینترنتی، مانند پستهای رسانههای اجتماعی، به طور بالقوه راهی آسان برای افزایش اندازه کلی مجموعه داده است.

مدل های ML در هر اندازه ای

یک نمونه خوب از یک مدل عظیم هوش مصنوعی، آخرین مدل زبان گوگل است که اندازه باورنکردنی 1.6 تریلیون پارامتر دارد – برای ما بسیار بزرگ است که عملاً آن را درک کنیم، اگرچه برای مقایسه، فقط 86 میلیارد نورون در مغز انسان وجود دارد.

در عین حال، می توان مدل های یادگیری ماشینی ساخت که حدود 10 مرتبه کوچکتر از مدل زبان گوگل هستند.

به عنوان مثال، پرسپترون یک طبقه بندی است که در دهه 1950 ساخته شد. این شبکههای عصبی تک لایه با اختصاص دادن ورودیها به خروجیهای مختلف آموزش داده میشوند و شبکه وزن خود را تا زمانی که بتواند خروجی ورودیهای جدید را به درستی پیشبینی کند، تنظیم میکند. پرسپترون به دلیل کمبود حافظه و عدم توانایی در برون یابی روابط بین نقاط داده ای که ممکن است ندیده باشد محدود شده است، اما در هسته خود، می تواند اساس یک مدل عملکردی با تنها چند پارامتر باشد.

کمیت همه چیز نیست

مهم است که به یاد داشته باشید که کمیت همه چیز در مورد داده ها نیست. حتی اگر داده های زیادی داشته باشید، ممکن است مدل شما به خوبی کار نکند. برای داشتن مدل های باکیفیت، به داده هایی با کیفیت بالا نیاز دارید. این به این معنی است که داده های شما باید تمیز و کار با آنها آسان باشد تا بتوان از آنها به طور موثر استفاده کرد.

به عبارت دیگر، بهتر است یک مجموعه داده کوچک و با کیفیت بالا داشته باشید که نشاندهنده مشکلی باشد که میخواهید حل کنید، تا یک مجموعه داده بزرگ و عمومی که مملو از مشکلات کیفیت باشد.

پس از همه، همه داده ها ارزشمند نیستند. همانطور که نیت سیلور، بنیانگذار FiveThirtyEight، میگوید: «هر روز، سه بار در ثانیه، معادل مقدار دادهای که کتابخانه کنگره در کل مجموعه چاپی خود دارد، تولید میکنیم، درست است؟ اما بیشتر آن مانند ویدیوهای گربه در یوتیوب یا افراد 13 ساله است که در مورد فیلم بعدی گرگ و میش پیام های متنی رد و بدل می کنند.

آزمایش کنید تا متوجه شوید به چه مقدار داده نیاز دارید

یادگیری ماشینی آسانتر و سریعتر میشود. نیازی به هدر دادن زمان زیادی برای آماده سازی نیست، زیرا یک مجموعه داده عظیم پیش نیاز نیست. همانطور که آدام ساویج می گوید: “در روح علم، واقعا چیزی به نام “آزمایش ناموفق” وجود ندارد.” به سادگی آزمایش کنید و ببینید به چه مقدار داده نیاز دارید.

در چند سال اخیر، یادگیری ماشین و ابزارهای هوش مصنوعی سادهتر و سریعتر شدهاند. روزهای انتظار هفته ها یا ماه ها برای ساخت و استقرار مدل ها به پایان رسیده است. با Akkio، میتوانید یک مدل را در کمتر از 10 ثانیه بسازید، به این معنی که فرآیند تعیین میزان دادهای که واقعاً برای یک مدل مؤثر نیاز دارید، سریع و بدون زحمت است.

با یادگیری ماشین سنتی، شما معمولاً به یک مجموعه داده بزرگ نیاز دارید تا داده های آموزشی کافی به دست آورید. اما با Akkio، می توان مدل های قانع کننده ای با حداقل 100 یا 1000 نمونه ایجاد کرد. همانطور که بررسی کردیم، اگر متوجه شدید که با مجموعه دادههای کوچک نتایج عالی کسب نمیکنید، همیشه میتوانید دادههای جدید، تقویت دادهها، پلتفرمهای جمعسپاری یا صرفاً به منابع داده آنلاین روی آورید.

آماده سازی داده ها برای یادگیری ماشینی

آمادهسازی دادههای شما برای آموزش یک مدل یادگیری ماشینی میتواند از اتصال ساده پلتفرمهای فناوری عملیات تجاری موجود (Salesforce، Marketo، و Hubspot، و غیره) و فروشگاههای داده (Snowflake، Google Big Query و غیره) تا بهداشت دادههای تجاری گسترده باشد. برنامههایی که ماهها طول میکشد، اما دادههای تمیزی را برای عملکرد بهینه به دست میآورند. همچنین باید مجموعه داده مورد استفاده برای آموزش را محدود کنید تا زمانی که میخواهید یک نتیجه کلیدی را پیشبینی کنید، اطلاعات در دسترس شما باشد. ما Akkio را طوری طراحی کردهایم که با دادههای نامرتب و همچنین تمیز کار کند – و معتقدیم که 90٪ از ارزش یادگیری ماشینی را با کسری از هزینه یک طرح بهداشتی دادهها به دست میآوریم. برای کسب اطلاعات بیشتر درباره آمادهسازی دادههای خود برای یادگیری ماشینی، اینجا را کلیک کنید.

افزایش داده برای یادگیری ماشین

عملکرد یک مدل یادگیری ماشین در درجه اول به دقت پیشبینی مجموعه داده آموزشی آن با توجه به نتیجه مورد علاقه بستگی دارد. اگر بتوانید همه چیز را در مورد یک سیستم بدانید (به کنار فیزیک کوانتومی)، میتوانید وضعیت آینده آن را کاملاً پیشبینی کنید. در واقع، بیشتر مجموعههای داده حاوی زیرمجموعه کوچکی از اطلاعات در مورد یک سیستم هستند – اما این اغلب برای ساخت یک مدل ارزشمند ML کافی است. گفته می شود، افزودن داده های اضافی اغلب می تواند به بهبود عملکرد پیش بینی کمک کند. به این کار افزایش داده می گویند. برای کسب اطلاعات بیشتر درباره افزایش داده برای یادگیری ماشین، اینجا را کلیک کنید.

تعصب در یادگیری ماشینی: چیست و چگونه می توان از آن اجتناب کرد؟

یکی از موارد بسیار مهمی که هنگام استفاده از یادگیری ماشین باید از آن آگاه بود این است که سوگیری در مجموعه داده مورد استفاده برای آموزش مدل در تصمیم گیری خود مدل منعکس می شود. گاهی اوقات این سوگیری ها در داده های شما آشکار نیستند – برای مثال کد پستی یا پستی را در نظر بگیرید. اطلاعات مکان اطلاعات زیادی را رمزگذاری می کند که ممکن است در نگاه اول واضح نباشد – همه چیز از آب و هوا گرفته تا تراکم جمعیت گرفته تا درآمد، مسکن و اطلاعات جمعیتی مانند سن و قومیت. این الگوها میتوانند مفید باشند، اما در صورت استفاده از مدلها به روشهایی که نتایج تبعیضآمیز ناخواسته (هم از نظر اخلاقی و هم از نظر قانونی) را تقویت میکنند، پتانسیل مضر بودن را نیز دارند. اینجا را کلیک کنید تا درباره سوگیری در یادگیری ماشینی و نحوه به حداقل رساندن آن بیشتر بدانید.

از موارد یادگیری ماشین استفاده کنید

یادگیری ماشینی زیرمجموعهای از هوش مصنوعی است که بر سیستمهایی متمرکز است که میتوانند از دادهها یاد بگیرند.

در حالی که برخی از کاربردهای برتر یادگیری ماشینی را در تعدادی از صنایع بررسی خواهیم کرد، دنیای دانشگاهی نیز از هوش مصنوعی استفاده میکند، تا حد زیادی برای تحقیقات در زمینههایی مانند زیستشناسی، شیمی، و علم مواد.

انرژی

انرژی تجدید پذیر

انرژی های تجدیدپذیر یکی از سریع ترین منابع تولید برق در سراسر جهان است. در سال 2020، 80 درصد از ظرفیت جدید برق در سطح جهان را به خود اختصاص داد.

هوش مصنوعی برای پذیرش موفقیت آمیز حیاتی است. هوش مصنوعی میتواند نیازهای عرضه و تقاضای برق را در زمان واقعی متعادل کند، استفاده و ذخیرهسازی انرژی را برای کاهش نرخها بهینه کند و به ادغام منابع جدید و پاک در زیرساختهای موجود کمک کند. هوش مصنوعی همچنین می تواند با یادگیری از رویدادهای گذشته، قطع برق در آینده را پیش بینی کرده و از آن جلوگیری کند.

به عنوان مثال، هنگامی که یک شبکه تحت فشار تقاضا قرار می گیرد، هوش مصنوعی می تواند مسیر جریان انرژی و مصرف برق آن شبکه را پیش بینی کند، سپس برای جلوگیری از قطع برق اقدام کند. هوش مصنوعی همچنین می تواند زمان وقوع قطع برق در آینده را پیش بینی کند، بنابراین شرکت های برق می توانند اقدامات پیشگیرانه ای را برای به حداقل رساندن اثرات قطعی انجام دهند.

علاوه بر این، هوش مصنوعی حتی می تواند به انرژی باد کمک کند. قدرت باد همیشه وجود دارد، اما مهار آن آسان نیست. آسیابهای بادی برای قرنها برای جذب نیروی باد مورد استفاده قرار میگرفتند، اما این فرآیند دشوار و پرهزینه است.

اما اکنون هوش مصنوعی می تواند بازی را تغییر دهد. هوش مصنوعی میتواند محاسبه کند که توربینهای بادی چگونه باید بچرخند به طوری که کمترین تعداد توربینهای ممکن در سایه باد دیگری قرار بگیرند. با استفاده از داده های جمع آوری شده از زمین، ارتفاع و اندازه توربین ها و داده های هواشناسی، هوش مصنوعی می تواند نحوه چرخش توربین های بادی را برای مهار باد تعیین کند.

بیمه

قیمت گذاری بیمه

صنعت بیمه به شدت رقابتی است. واقعیت ساده این است که اگر به طور مداوم سودآور نباشید، از بازار رانده خواهید شد. برای حفظ سودآوری، شرکت های بیمه باید بتوانند به طور دقیق افراد پرخطر و پرهزینه را پیش بینی کنند.

در واقع، داده ها نشان می دهد که 70 درصد از شرکت های بیمه جدید آمریکای شمالی ظرف 10 سال شکست می خورند. این وضعیت موجود است، زیرا شرکت های بیمه اغلب نمی توانند به طور دقیق برنامه های خود را قیمت گذاری کنند، که منجر به زیان های عظیم می شود.

نشان داده شده است که هوش مصنوعی در پیشبینی هزینههای ادعاهای آتی بسیار دقیق است. این دقت به شما این امکان را می دهد که ریسک بیمه کردن یک فرد را بر اساس سابقه مطالبات گذشته آنها ارزیابی کنید و از این اطلاعات برای قیمت گذاری صحیح حق بیمه خود استفاده کنید.

این بسیار مهم است زیرا به شما این امکان را می دهد که در یک صنعت پر خطر که در آن همیشه در معرض خطر حذف شدن از تجارت با انتخاب نامناسب هستید، سودآور بمانید.

با Akkio، مدلسازی هزینه مبتنی بر هوش مصنوعی را میتوان با کلیک انجام داد، و به بیمهگران این امکان را میدهد تا رقبای خود را که با استفاده از مدلهای هزینه سنتی، پرزحمت و نادرست گیر کردهاند، پیشی بگیرند. این مدل سازی هزینه یکی از بزرگترین مشکلات بیمه گذاران امروزی را حل می کند: انتخاب چه کسی و با چه نرخی.

مدل سازی توسعه دعوی

در صنعت بیمه، همه چیز در مورد مدیریت ریسک است. و هنگامی که در مورد ریسک پیش بینی می کنید، می خواهید آن را به درستی انجام دهید. در گذشته، صنعت بر تکنیکهای مدلسازی قدیمی تکیه میکرد که اغلب منجر به ادعای قیمتگذاری کمتر یا بیش از حد میشد. که منجر به حق بیمه بالاتر برای مصرف کنندگان و انبوهی از مشکلات دیگر شد.

اما هوش مصنوعی این مشکل را حل می کند. با استفاده از این تکنیکهای جدید یادگیری ماشین، میتوان بهطور دقیق هزینه ادعا را پیشبینی کرد و مدلهای پیشبینی دقیق را در عرض چند دقیقه ساخت. نه تنها این، بلکه بیمهگران حتی میتوانند مدلهایی را برای پیشبینی چگونگی تغییر هزینههای خسارت بسازند و تغییرات تخمین موردی را محاسبه کنند.