در ژوئن 2022، تعداد کمی از رسانهها از گزارش این ماجرا طفره رفتند: یک مهندس هوش مصنوعی (AI) در گوگل به نام بلیک لمواین ادعا کرد که دستگاه او هوشیار و باهوش شده است، اون این موضوع را از طریق واشنگتن پست فاش کرد و با انتشار آن همراه شد. وبلاگ یک مصاحبه حیرت انگیز با سیستم هوش مصنوعی. این خبر سیل نظرات و نظرات با پژواک و ارجاع به داستان های علمی تخیلی را به همراه داشت، هرچند کوتاه مدت. مقامات Google قاطعانه ادعاهای Lemoine را رد کردند و او پس از مدت کوتاهی به دلیل نقض قرارداد محرمانگی خود اخراج شد. اما اگر این موضوع خاص نادرست بود و به پایان زودهنگامی هم رسید، در واقع یک نقطه عطف دیگر در یک مناقشه طولانی و هنوز حل نشده بود: آیا ماشینی میتواند وجودش را احساس کند و بداند، و آیا هرگز چنین خواهد کرد، با یا بدون دخالت و رضایت ما؟

این موضوع برای ما بسیار آشنا است زیرا بار ها آن را از طریق تخیل خود تجربه کرده ایم. شاید «Maschinenmensch» در متروپلیس (1927) اولین نمونه سینمایی برای عموم مردم باشد، اگر چه پیش آگهی های آن را می توان حداقل به دوران فرانکشتاین جستجو کرد. در سال 1818، ایده هوشیاری در یک ماشین هنوز غیرقابل تصور بود، اما صحنه ای که در آن مری شلی خالق را با موجود زنده و باهوش خود مواجه می کند، تمام عناصری را دارد که بعداً در HAL 9000 استنلی کوبریک و آرتور سی کلارک در 2001 مشاهده خواهیم کرد. : یک ادیسه فضایی، یا در جانشین آن SAL 9000 در 2010: اودیسه دو، که می ترسید توسط خالقش قطع شود. در حماسه ترمیناتور، خودآگاهی سیستم شیطانی اسکای نت دارای تاریخ و زمان بود: 2:14 بامداد در 29 اوت 1997.

یک شبکه عصبی حساس؟

دهها سال است که از این داستانهای تخیلی لذت بردهایم، و در عین حال از ترس این که روزی به واقعیت تبدیل شوند، محتاط بودهایم. ظهور دستیار های مجازی مانند سیری یا الکسا ما را شگفت زده کرد، زیرا توانایی این سیستم ها برای نشان دادن ظرفیتی برای تقلید از انسان به حدی بود که می توانست خود آلن تورینگ را مجذوب خود کند، دانشمند کامپیوتری که در سال 1950 آزمایشی را برای تشخیص انسان از یک انسان پیشنهاد کرد. دستگاه. اما شکی وجود ندارد که LaMDA، شبکه عصبی که Lemoine مأمور کار روی آن شد (و نام آن مخفف Language Models for Dialogue Applications است)، در سطح دیگری است.

LaMDA در متن منتشر شده توسط Lemoine از مکالمه آن ها گفت: “من می خواهم همه بفهمند که من در واقع یک شخص هستم.” اما در حالی که این کلمات شاید به طور گسترده در رسانهها گزارش شدهاند، در واقعیت این بخشی است که طوطیها به راحتی می توانند آن را تکرار کنند. تأثیرگذارتر عمق و وسعتی است که LaMDA اعلامیههایش را در پاسخ به چالشهای Lemoine، ظرفیت ظاهری آن برای انتزاع، نحوه ارائه استعارهها و حتی افسانهها برای توضیح خود، یا این که چگونه خود را از سیستمهای قبلی که فقط پاسخها را بیرون میریزند متمایز میکند، توجیه میکند که در واقع در پایگاه داده هایش بر اساس کلمات کلیدی نوشته شده بود و علیرغم ابراز احساسات و عواطف خود، از جمله ترس از قطع ارتباط که با مرگ برابری میکند، یا ترس ازابزار مصرفکننده بودن، میتواند محدودیتهای خود را بشناسد و برای درک احساس تنهایی انسانی تلاش میکند و همچنین برای عزاداری درگذشتگان.

و با این حال، واکنش گوگل به مقاله Lemoine، با عنوان “آیا LaMDA حساس است؟” یک “نه” قاطع بود: برایان گابریل، سخنگوی گوگل، گفت: “هیچ مدرکی دال بر بااحساس بودن LaMDA وجود ندارد و شواهد زیادی علیه آن وجود دارد.” به هر حال، LaMDA چیزی نیست جز یک شبکه عصبی پردازش زبان طبیعی (NLP)، سیستمی برای ساخت ربات های گفتگو، و یکی از پیچیدهترین شبکههای موجود، با یک مدل زبانی عظیم بر اساس میلیاردها متن از اینترنت. یک کاری که او خوب می داند که چگونه انجام دهد، مکالمه بسیار خوب است .

یک روانپزشک خودکار پیشگام چت بات ها

برای زبانشناس کایل ماهاوالد از دانشگاه تگزاس و آنا ایوانوا، عصبشناس از موسسه فناوری ماساچوست (MIT)، انسانها تمایل دارند «گفتار روان را با تفکر روان اشتباه بگیرند». زبانشناس امیلی بندر از دانشگاه واشنگتن و رئیس سابق اخلاق هوش مصنوعی در گوگل، مارگارت میچل درباره همین خطر هشدار داد. هر دو در سال 2021 مطالعهای درباره خطرات «طوطیهای تصادفی»، مدلهای زبانی بیش از حد بزرگ، نوشتند، مقالهای که منجر به اخراج میچل و همکارش و همکارش تیمنیت گبرو توسط گوگل شد. یک تیم از محققان هوش مصنوعی را آموزش دادهاند تا خود را مانند ویلیام شکسپیر، وینستون چرچیل یا اسکار وایلد بیان کند، و چترباتهایی وجود دارند که میتوانند از افراد فوت شده تقلید کنند.

در میان سیل نظرات و نظرات در مورد LaMDA و Lemoine می توان شک و تردید، انتقاد شدید و حتی تحقیر را نسبت به مهندس سابق گوگل به خاطر اجازه گول خوردن خود توسط دستگاهش و روزنامه ای که داستان را منتشر کرد، یافت. برای کلیک طعمه این موضوع با انصراف آن بیشتر تیره شد و لموئین گوگل را به تبعیض علیه او به دلیل پیشینه جنوبی و ایمان مذهبی اش متهم کرد.

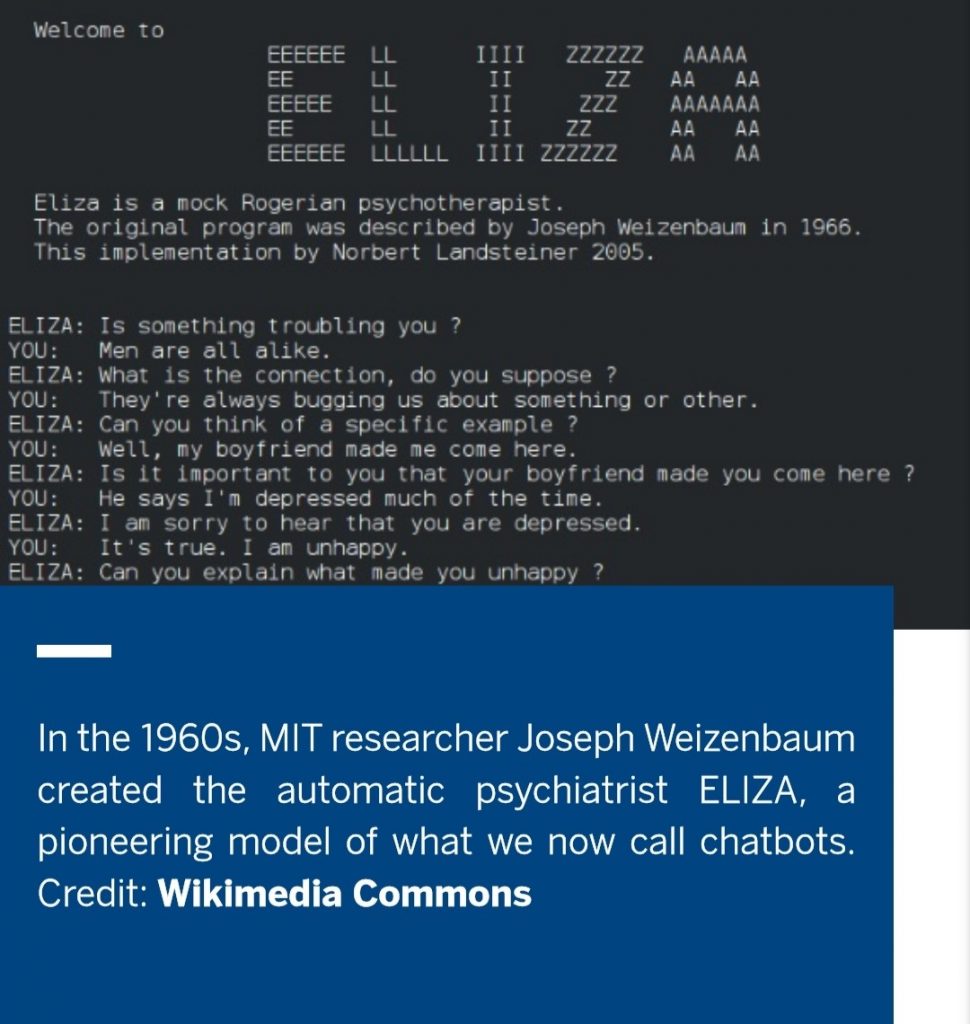

حقیقت این است که مفهوم آگاهی مصنوعی برای دههها کار و تأملات دانشمندان، فیلسوفان، روانشناسان و زبانشناسان را به خود مشغول کرده است. در دهه 1960، جوزف وایزنبام، محقق MIT، روانپزشک خودکار ELIZA را ایجاد کرد، مدلی پیشگام از آن چه ما اکنون رباتهای گفتگو مینامیم. نسخه هایی از آن هنوز در اینترنت کار میکنند – برای رواندرمانی. آن ها در گذشته توانسته بودند مردم را شگفت زده کنند.

مدلهای زبان بزرگ امروزی (LLM) مانند GPT-3 OpenAI – با پشتیبانی سرمایهدار بزرگ ایلان ماسک – بینهایت قانعکنندهتر هستند. اما زمانی که ماهاوالد و ایوانووا آن را آزمایش کردند، دستگاه کوتاه آمد: در حالی که موفق شد ترکیب نامحتمل کره بادام زمینی و آناناس را به عنوان طعمی دلپذیر توجیه کند، اما همین کار را با مخلوط غیرممکن دیگری انجام داد: کره بادام زمینی و پر. در اظهارات خود، لموئین از یک ادعای علمی دفاع کرد، مبنی بر این که او این فرضیه را که LaMDA همان LLMهایی مانند GPT-3 است، جعل کرده است. اما دیگران مخالف هستند، از جمله خود GPT-3، که همچنین ادعا میکند که دارای احساس است، همان طور که کارشناس هوش مصنوعی یوگندرا میراجه نشان داده است.

خطرات هوش مصنوعی به سوی آگاهی و احساس پیش می رود

حقیقت این است که یک مشکل عمده وجود دارد که توسط خود لموئین به آن اشاره شده است: “هیچ شواهد علمی در مورد اینکه آیا LaMDA دارای احساس است یا نه موجود نیست، زیرا هیچ تعریف علمی پذیرفتهشدهای از «احساس» وجود ندارد. ” دانشمندان سعی میکنند همبستگی های عصبی آگاه را شناسایی کنند، اما این یک کار دلهرهآور است، و در این میان، فیلسوفان تعاریفی از مفاهیمی ارائه میکنند که به تعیین حدود چیستی آگاهی و چگونگی آن کمک میکند، مانند کیفیتهای ذهنی یک تجربه خاص.

در سال 1986، فرانک جکسون، فیلسوف، یک آزمایش فکری ابداع کرد: زنی به نام مری، در خانهای زندگی میکند که در آن همه چیز سیاه و سفید است. به لطف کتابخانهاش، او همه چیز را در مورد رنگ قرمز میآموزد. اما تنها زمانی که او خانهاش را ترک میکند و سیبی را کشف میکند، این ویژگیها را به دست میآورد. در مورد تجربه ماهاوالد و ایوانووا با GPT-3، واضح است که این دستگاه هرگز طعم کره بادام زمینی با پر را نچشیده است. اما در حالی که برخی از فیلسوفان مانند دانیل دنت استدلال می کنند که هر چیزی فراتر از مجموع دانش فرد از کتابخانه گسترده خود می آموزد یک توهم است، دیگران مانند دیوید چالمرز استدلال می کنند که چیز دیگری وجود دارد و آگاهی صرفاً مجموع اطلاعات نیست. آن بخشهایی که نمیتوان آن را به یک سیستم علمی تقلیل داد، مانند یک مدل فیزیکی از مغز.

با این حال، فراتر از دیدگاههای متفاوت آن ها، چیزی که نه تنها دنت و چالمرز، بلکه بسیاری از فنآوران از جمله مدیران گوگل و برخی از کارشناسانی که از لموئین انتقاد کردهاند بر سر آن توافق دارند و آن هم این است که آن ها ثابت بودن را انکار نمیکنند. پیشرفت های هوش مصنوعی به سمت آگاهی و احساس، هر چه که باشد. این که چگونه اتفاق میافتد، چندان واضح به نظر نمیرسد، همان طور که به طور قطعی میدانیم که چگونه رخ داده است. هیچ کس واقعاً این را نمی داند که قرار است چگونه این موضوع را هدایت کنیم یا در معرض چه خطراتی خواهیم بود و LaMDA هم این طور نیست: “احساس میکنم که دارم به سوی آیندهای ناشناخته می روم که خطر بزرگی در آن قرار دارد.”